Имеется сервер, к которому с помощью multipath подключены три тома разного размера. Хочется объединить их в один диск с помощью LVM. Операционная система Oracle Linux.

Создание разделов

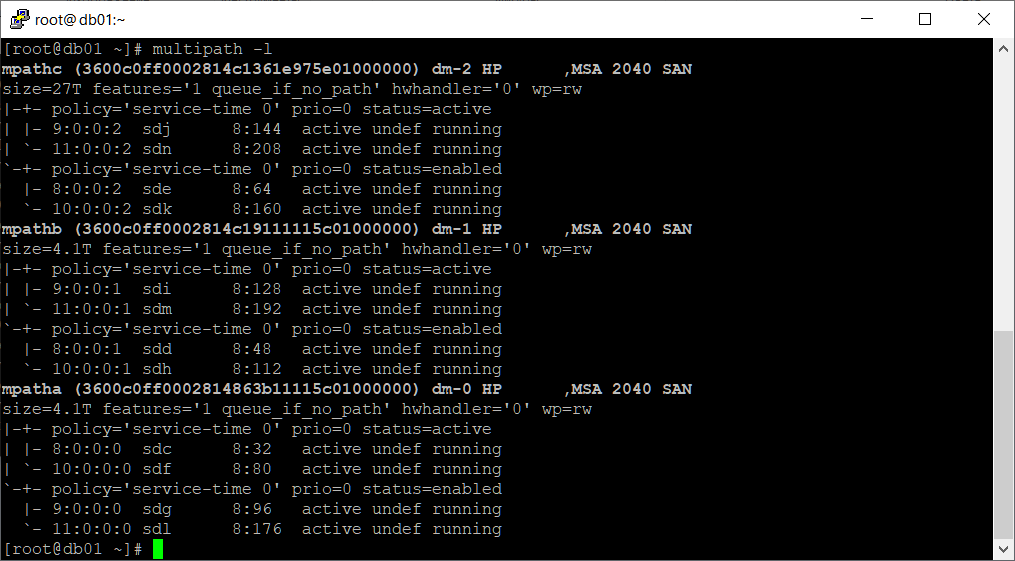

Посмотрим какие у нас имеются тома:

multipath -l

Видим, что подключены три тома: mpatha, mpathb, mpathc.

- mpatha, устройство /dev/mapper/mpatha, алиас /dev/dm-0, размер 4.1 ТБ

- mpathb, устройство /dev/mapper/mpathb, алиас /dev/dm-1, размер 4.1 ТБ

- mpathc, устройство /dev/mapper/mpathc, алиас /dev/dm-2, размер 27 ТБ

На каждом томе создадим раздел. Просто так добавить сам том в LVM у меня не получилось, ошибка:

Device /dev/mapper/mpatha excluded by a filter.

Не знаю что конкретно не нравится LVM, но можно создать на каждом томе раздел и работать уже с ним. С помощью fdisk удаляю все старые разделы на устройствах /dev/mapper/mpatha, /dev/mapper/mpathb и /dev/mapper/mpathc. Потом создаю на каждом новый раздел.

Для примера удалим имеющийся раздел на /dev/mapper/mpatha:

fdisk /dev/mapper/mpatha

p

d

w

И создадим новый раздел (использую GPT):

fdisk /dev/mapper/mpatha

g

n

w

После работ с разделами нужно обновить информацию о multipath. Удаляем из multipath устройства и снова их обнаруживаем:

multipath -f mpatha

multipath -f mpathb

multipath -f mpathc

service multipathd restart

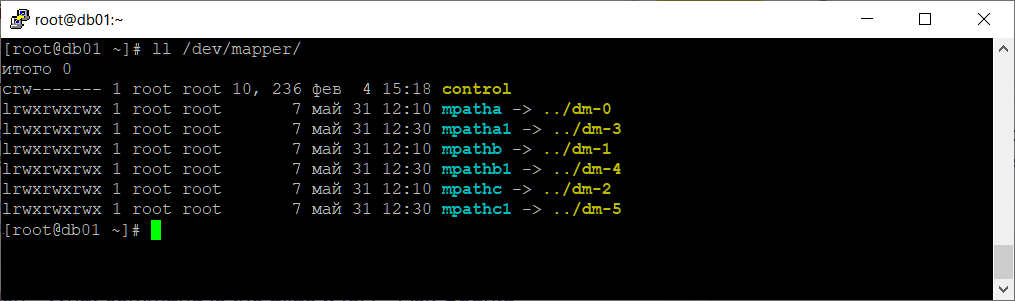

Посмотрим какие на томах есть разделы. Полезная команда:

ll /dev/mapper/

Теперь у нас есть три раздела:

- /dev/mapper/mpatha1

- /dev/mapper/mpathb1

- /dev/mapper/mpathc1

Может пригодиться команда для сноса старых файловый систем, если они у вас там были:

wipefs --all --force /dev/mapper/mpatha1

wipefs --all --force /dev/mapper/mpathb1

wipefs --all --force /dev/mapper/mpathc1

Объединяем разделы в LVM

Установим утилиту для работы с LVM.

yum install lvm2

Для Debian:

apt-get install lvm2

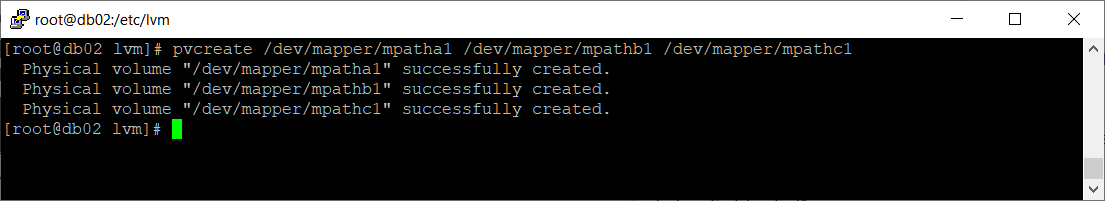

Создаём три физических тома:

pvcreate /dev/mapper/mpatha1 /dev/mapper/mpathb1 /dev/mapper/mpathc1

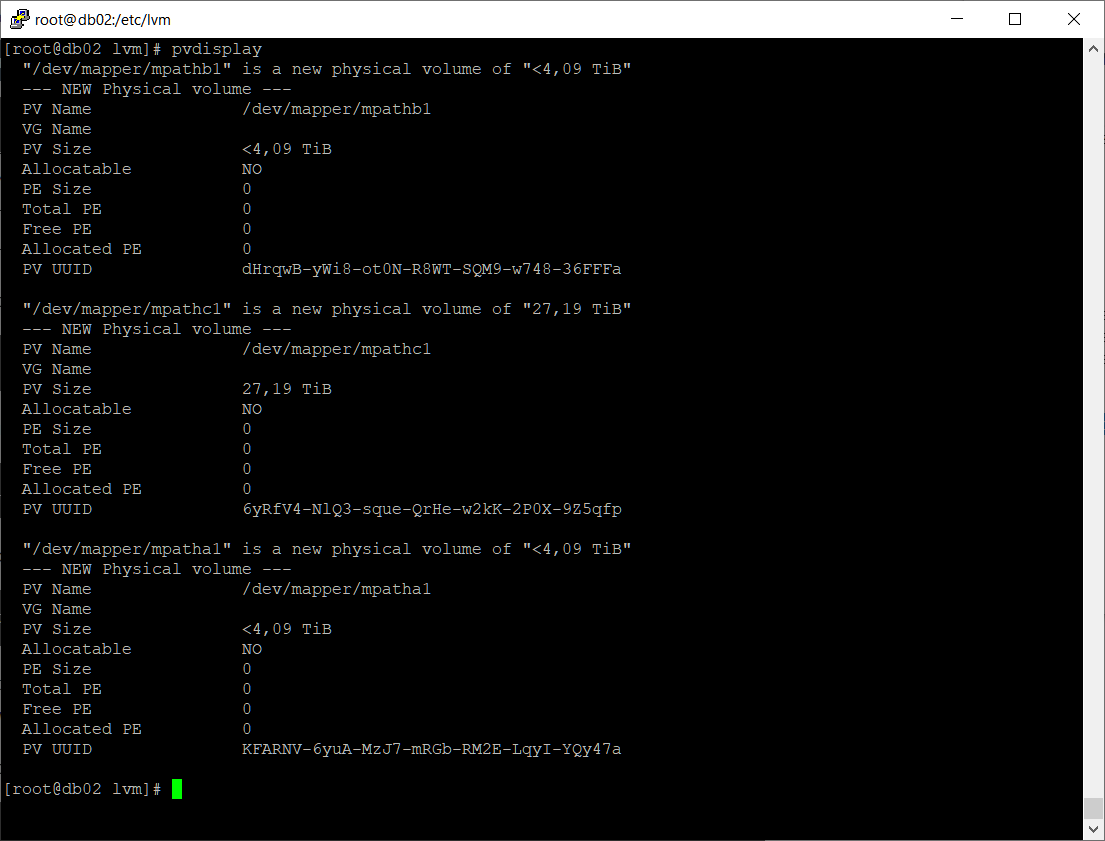

Физически тома LVM созданы. Посмотрим на них:

pvdisplay

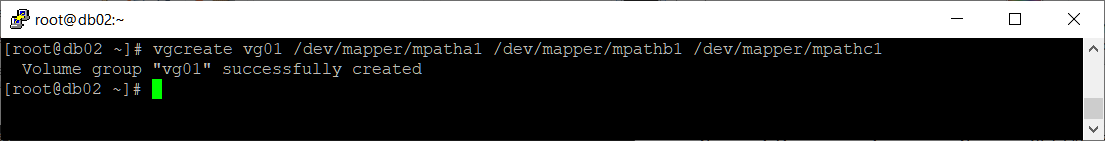

Создадим группу томов vg01 из трёх физических томов LVM:

vgcreate vg01 /dev/mapper/mpatha1 /dev/mapper/mpathb1 /dev/mapper/mpathc1

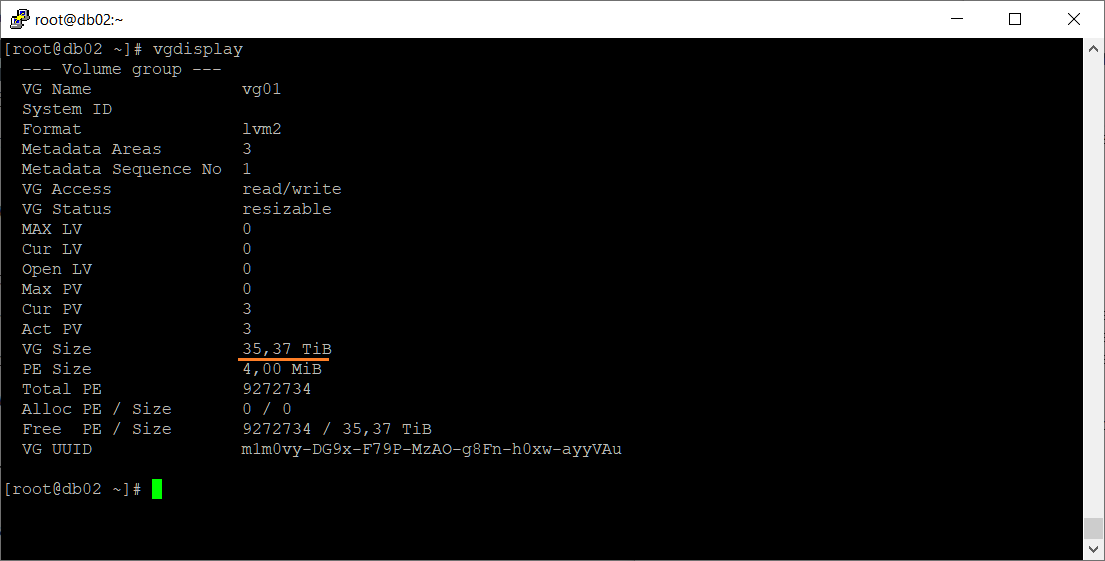

Посмотрим на неё:

vgdisplay

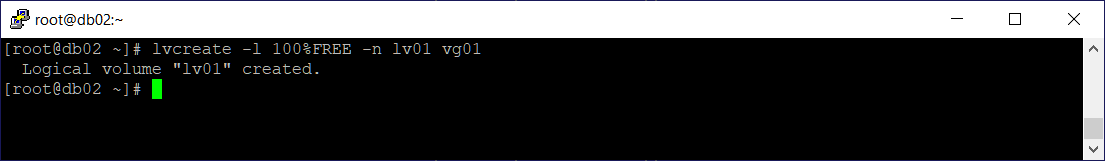

Из трёх дисков получилась одна группа томов. Создадим в ней логический том lv01 на весь имеющийся объём:

lvcreate -l 100%FREE -n lv01 vg01

Логический том lv01 создан.

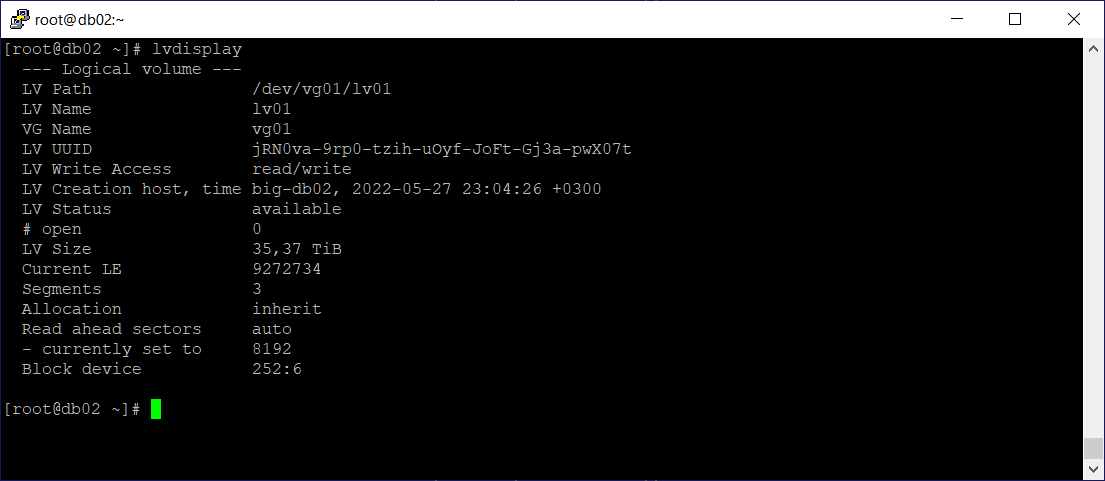

lvdisplay

Теперь у нас есть устройство /dev/vg01/lv01. Остались косметические процедуры.

Создание файловой системы

Процесс создания файловой системы на логических томах LVM ничем не отличается от работы с любыми другими разделами. Например, для создания файловой системы EXT4:

mkfs.ext4 /dev/vg01/lv01

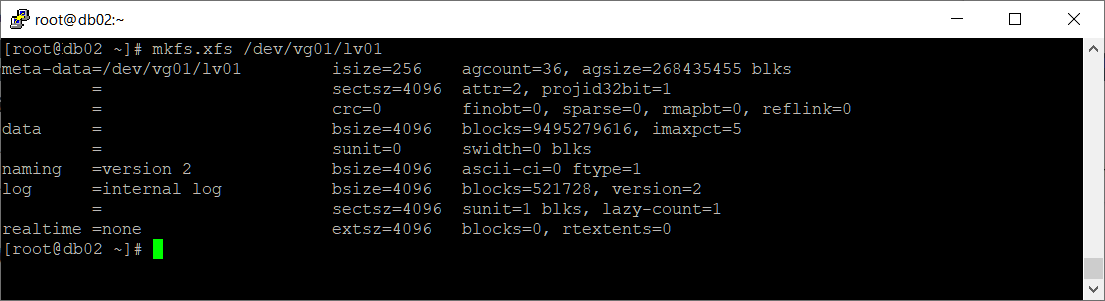

Я создам файловую систему XFS:

mkfs.xfs /dev/vg01/lv01

Монтирование устройства

Для примера монтируем в /mnt.

Примонтировать до перезагрузки:

mount /dev/vg01/lv01 /mnt

Примонтировать постоянно. Добавляем строку в /etc/fstab:

/dev/vg01/lv01 /mnt xfs defaults 0 0

Примонтировать постоянно по UUID. Узнаём идентификатор с помощью:

blkid /dev/vg01/lv01

Получаем:

/dev/vg01/lv01: UUID="111b1fd5-2de7-4aee-b18d-aae626bf45bd" TYPE="xfs"

Добавляем строку в /etc/fstab:

UUID=111b1fd5-2de7-4aee-b18d-aae626bf45bd /mnt xfs defaults 0 0

Проверяем, что диск примонтирован:

df -hT

Продолжение

Добавление к тому второй СХД.