Развитие вычислительных систем идёт ускоренными темпами. Частоты процессоров растут, объём оперативной памяти и общая производительность повышается. Чтобы твой компьютер купили, нужно постоянно выдавать что-то новенькое и более производительное. Наступил момент, когда рост производительности замедлился, упёрлись в физические пределы технологий. А запросы рынка продолжали расти.

Производители пошли по другому пути — мультипроцессорные системы. Два или четыре процессора на материнской плате: производительность вдвое больше. К тому же для выпуска на рынок мультипроцессорных систем не требовалось больших изменений. Это дало новый толчок развитию вычислительных систем. Больше ядер на кристалле, даже в ущерб частотам. Даже операционные системы не пришлось сильно модернизировать: да здравствует виртуализация! Всё больше и больше ядер в сервере, а значит и в стойке, и в ЦОДе.

Вертикальное масштабирование технологий перевели в горизонтальное. Теперь для наращивания мощностей достаточно введения в строй нового вычислительного кластера. И тут снова упёрлись, теперь в деньги. Крупными заказчиками суперкомпьютеров были государственные структуры, они могли позволить себе выделить на такие проекты любые средства. Со временем потребность в больших вычислительных мощностях появилась у коммерческих структур, а бизнес умеет считать деньги.

На обслуживание информационной инфраструктуры требуются ресурсы: оборудование, питание, охлаждение, обслуживание парка техники, обучение и заработная плата персонала. От производительности системы мы плавно переходим к эффективности вычислений. Бизнес стал задумываться над снижением затрат при сохранении той же вычислительной мощности. Как грибы стали появляться и реализовываться интересные идеи: погружное охлаждение необслуживаемых стоек, водяное охлаждение серверов, использование отведённого тепла для нагрева воды. Но всё это частности, требовалось что-то более радикальное, какой-то новый путь.

В 2009 году в дебрях компании Facebook появилась идея о переосмыслении своей инфраструктуры. Именно тогда Facebook начал проект по разработке самого энергоэффективного центра обработки данных в мире, который мог бы работать в беспрецедентных масштабах при минимально возможных затратах. Небольшая группа инженеров провела следующие два года, проектируя и создавая с нуля: программное обеспечение, серверы, стойки, блоки питания и охлаждение. Результат сейчас стоит в Прайнвилле, штат Орегон. В апреле 2011 года Facebook выступает с инициативой открыто делиться наработками в области разработок продукции для центров обработки данных. Гиганты IT индустрии поддержали начинание. В результате совместных усилий было организовано сообщество Open Compute Project — организация, участники которой обмениваются идеями и разработками для современных дата-центров. Впоследствии к организации стали присоединяться и более мелкие компании.

Пересмотру подлежало всё: машинные залы, стойки, сетевое оборудование, серверы, системы хранения данных, электропитание, охлаждение, интерфейсы, программное обеспечение, стандарты управления. Сейчас уже существует третья версия спецификации OCP 3.0, затрагивающая:

- Охлаждение

- ЦОД

- Управление оборудованием

- Сеть

- Прошивки

- Стойки и питание

- Безопасность

- Сервера

- Хранилища

- Телекоммуникация

- Синхронизация времени

- ...

Интересные идеи OCP

Вот, казалось бы, что можно улучшить в стандартной телекоммуникационной стойке?

К примеру, можно задаться простым вопросом: "Зачем стоечным серверам крышки?" И действительно, дно верхнего сервера прекрасно заменяет крышку нижнего сервера. Отлично, выкидываем крышки у всех серверов. Минус сто килограмм в стойке.

Придумываем дальше. В стойке бесят провода, спереди, сзади, сбоку. Было бы неплохо от них избавиться, но это сложно, сетевые порты бывают и со стороны холодного коридора, и со стороны горячего коридора. А зачем? Давайте уберём все сетевые порты на сторону холодного коридора. Отлично, все коммуникации выведены на фасад стойки, По бокам провода убраны, теперь там свободно. Что, свободно? Расширяем рабочее пространство стойки с 19 до 21 дюйма. Теперь на серверах можно порты разместить, а то не влезали.

И рельсы встроим сразу в стойку, чтобы все были одинаковые.

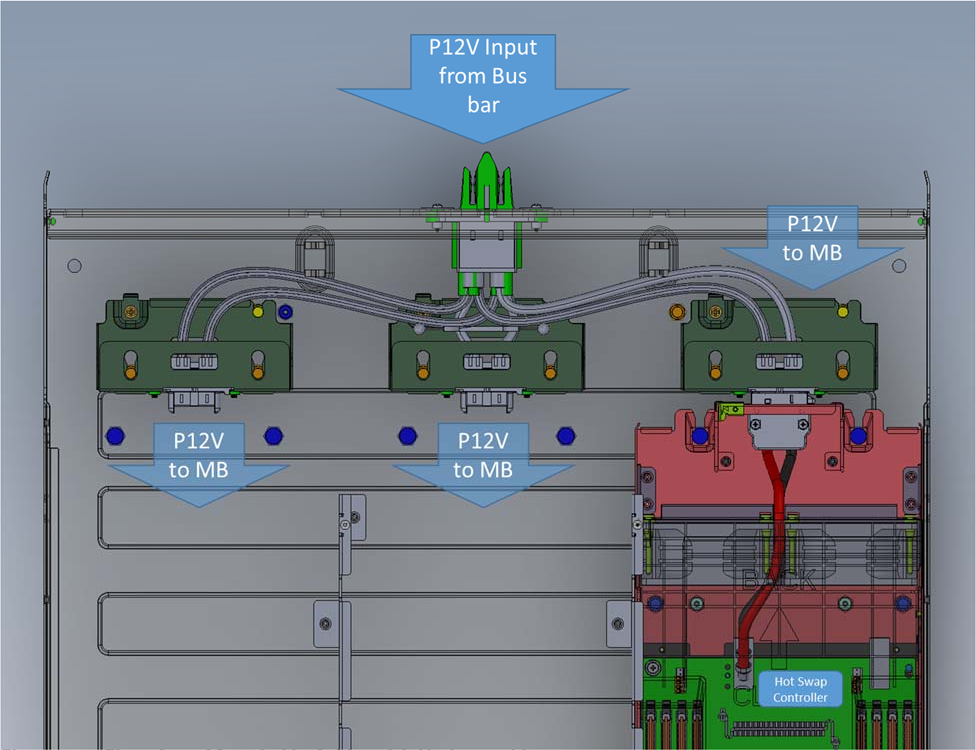

Сзади стойки остались только блоки питания. Много блоков питания, минимум два на каждое устройство. 40 серверов, 80 блоков питания, из них 40 блоков простаивает, может, выкинем их? Тогда как-то ненадёжно будет. Меняем концепцию, выкидываем все блоки питания! Вместо них ставим общую систему питания на всю стойку, естественно, с резервированием. В серверах место освободилось. Выкидываем все кабели питания и заменяем их на общую вертикальную шину. Задвигаешь сервер, он подключается к шине питания. Отлично, и со стороны тёплого коридора проводов не осталось, теперь туда даже ходить не нужно. Маленький штрих, шина выдаёт 12.7 Вольт, а не 220, что делает работу инженера более безопасной.

А давайте сделаем сервера чуть повыше? К примеру, один юнит будет 48 мм высотой (вместо 44.5 мм как у обычного юнита). Такой размер юнита был выбран не случайно, он, кстати, получил название OU — Open Unit, В 2OU сервер можно установить вентиляторы 180 мм, которые будут обеспечивать более эффективное охлаждение сервера. Это позволяет серверам выдерживать температуру до 35°C, можно повысить температуру холодного зала.

Набегаешься из тёплого зала в холодный, на следующие день насморк. Даёшь повышение температуры холодного зала!

Снижение требований к температуре позволяет экономить на охлаждении. ЦОД Facebook в Прайнвилле, на 38 % более энергоэффективный и на 24 % менее затратный в эксплуатации, чем на предыдущих объектах компании.

Да, юнит стал выше, но зачем ставить только один сервер. К примеру, можно в два юнита уместить сразу три сервера, тогда общая вместительность стойки не изменится. Одним из примеров такого сервера может послужить Tioga Pass. Tioga Pass имеет двухсокетную материнскую плату, которая использует форм-фактор 6.5 х 20 дюймов. Это первый сервер Facebook с двумя центральными процессорами, использующий OpenBMC.

Презентация Facebook OCP 2S Server Tioga Pass.

А вот обзор сервера Tioga Pass от отечественного производителя GAGAR-IN. Он же на фото выше.

Обслуживание всего оборудования производится вручную (tool less), отвёртка больше не нужна. 80% компонентов в OCP заменяются в течение 3 мин или быстрее. Все детали, которые можно нажимать, сдвигать, крутить и вертеть окрашены в салатовый цвет, который получил название OCP Green. Обслуживание стало быстрее, и не ткнёшь случайно отвёрткой кода не следует.

Системы хранения занимают второе место по важности после серверов. В концепции OCP большое распространение получили массивы JBOD (Just a Bunch Of Discs) и JBOF (Just a Bunch Of Flash), которые подключаются непосредственно к серверу и предоставляют диски в его операционную систему по интерфейсу SAS или шине PCIe. Благодаря увеличенной монтажной ширине оборудования в один ряд теперь можно установить пять HDD дисков, а не четыре, как в классической стойке.

Внедрение серверов, созданных в рамках проекта Open Compute, дало Facebook возможность сэкономить за три года более 2 млрд долларов. Экономия, это тот же самый доход, а бизнес не станет отказываться от дополнительного дохода. Для маленьких компаний OCP привлекателен тем, что решения, предлагаемые в рамках Open Compute Project, распространяются по аналогии с Open Source, т.е. бесплатно. Некоторые решения OCP, например, сетевые карты OCP NET 3.0, уже встречаются в классических серверах. Это позволяет упростить установку или замену сетевой карты без необходимости влезать в корпус сервера.

Инновации OCP стандартизируются, развиваются и постепенно внедряются в ЦОДах. Их использование удешевляет разработку серверных решений, которые становятся доступными для широкого круга заказчиков.