Очередная установка NVMe дисков в сервер, на этот раз требуется 4 диска объединить в RAID10 массив с помощью mdadm. Операционная система Oracle Linux.

Установка дисков

Диски объёмом 12.8 ТБ:

Samsung SSD MZPLJ12THALA-00007 — NVMe 12.8 ТБ

Устанавливаю в сервер HP ProLiant DL580 Gen9:

Сервер HPE Proliant DL580 Gen9 — обзор

Для данной модели сервера на диски устанавливается полнопрофильная планка. Установить можно до 9 устройств PCIe, у меня в сервере остался свободен только один слот.

После установки дисков и загрузки сервера выполняем:

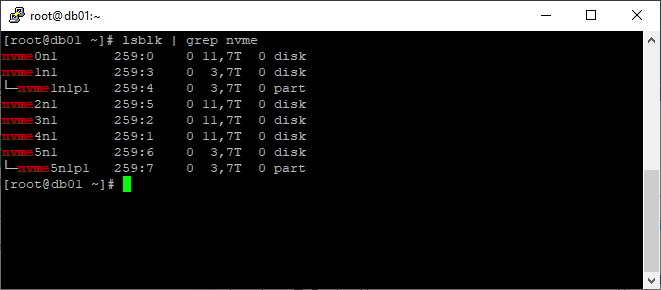

lsblk | grep nvme

Видим, что диски определились как nvme0n1, nvme2n1, nvme3n1 и nvme4n1. Определяем просто, на дисках нет раздела и объём отличается.

Подготовка GPT разделов

Создадим GPT разделы на дисках, а уже потом объединим их в RAID10 массив. Есть разные способы создать GPT раздел:

Linux — создать GPT раздел более 2 терабайт

Создаём GPT раздел на диске nvme0n1. Я использую fdisk:

[root@db01 ~]# fdisk /dev/nvme0n1

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table

Building a new DOS disklabel with disk identifier 0x73a5ab2b.

WARNING: The size of this disk is 12.8 TB (12800076283904 bytes).

DOS partition table format can not be used on drives for volumes

larger than (2199023255040 bytes) for 512-byte sectors. Use parted(1) and GUID

partition table format (GPT).

Команда (m для справки): g

Building a new GPT disklabel (GUID: 1E0E79AD-6B77-4403-8680-FDD127F32734)

Команда (m для справки): n

Номер раздела (1-128, default 1):

First sector (2048-25000148958, default 2048):

Last sector, +sectors or +size{K,M,G,T,P} (2048-25000148958, default 25000148958):

Created partition 1

Команда (m для справки): w

Таблица разделов была изменена!

Вызывается ioctl() для перечитывания таблицы разделов.

Синхронизируются диски.

Аналогично создаём GPT раздела на дисках nvme2n1, nvme3n1 и nvme4n1:

fdisk /dev/nvme2n1

fdisk /dev/nvme3n1

fdisk /dev/nvme4n1

Проверяем что получилось:

lsblk | grep nvme

У нас теперь есть четыре раздела:

- /dev/nvme0n1p1

- /dev/nvme2n1p1

- /dev/nvme3n1p1

- /dev/nvme4n1p1

mdadm — создаём RAID10

Проверим какие уже есть массивы:

cat /proc/mdstat

Уже есть md0, md1, md2. Создавать будем массив md30.

mdadm --create --verbose /dev/md30 -l 10 -n 4 /dev/nvme0n1p1 /dev/nvme2n1p1 /dev/nvme3n1p1 /dev/nvme4n1p1

Массив /dev/md30 создан, Идёт перестроение массива.

Массив перестроился:

Создаём файловую систему XFS:

mkfs.xfs /dev/md30

У меня этот процесс на работающем сервере занял часа четыре.

Определяем идентификатор:

blkid /dev/md30

В ответ получаем:

/dev/md30: UUID="95309d7e-b5ea-4f52-9b95-2f51da805cfe" TYPE="xfs"

Создаём директорию /u03 для монтирования:

mkdir /u03

В /etc/fstab добавляем опцию монтирования:

UUID=95309d7e-b5ea-4f52-9b95-2f51da805cfe /u03 xfs defaults 1 2

Монтируем:

mount -a

Проверяем:

df -h | grep u03

Теперь в системе есть новая папка на 24 ТБ.