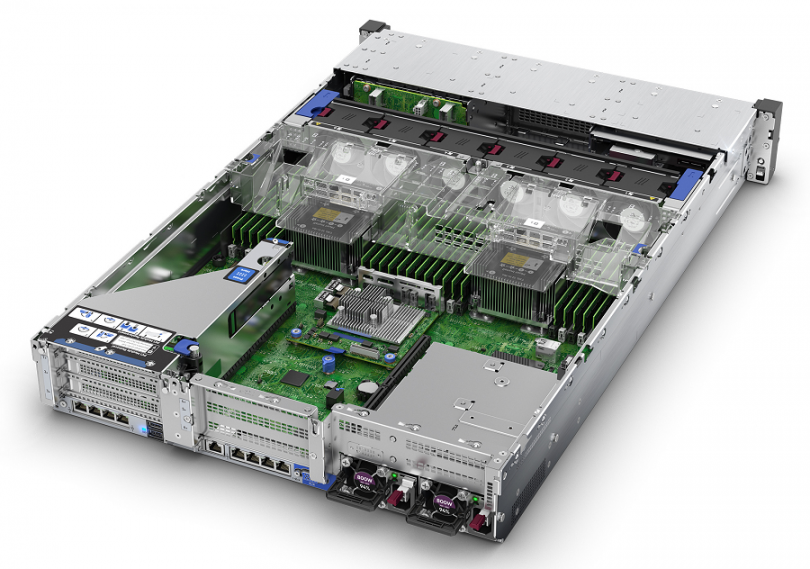

Всех приветствую. Сегодня мы решаем понятную задачу по расширению программного дискового массива в сервере HPE Proliant DL380 Gen10.

Имеем сервер HPE Proliant DL380 Gen10 с SFF шасси.

Сервер HPE Proliant DL380 Gen10 — SFF шасси

Первый отсек на 8 SFF, в нём у меня установлено 2 SAS диска 600 GB 10K. С помощью аппаратного RAID контроллера диски объединены в зеркальный массив RAID1. Здесь находится операционная система.

Второй отсек предназначен для установки 8 NVMe дисков. Занято 6 слотов дисками U.3 NVMe 6.4 TB.

Второй отсек предназначен для установки 8 NVMe дисков. Заняты все слоты дисками U.3 NVMe 6.4 TB.

Всего сейчас установлено 14 NVMe дисков, через mdadm NVMe диски собраны в RAID10 массив. Есть возможность добавить ещё два физических диска, чем мы и займёмся.

Добавляем диски

Пришли диски HPE 6.4TB NVMe x4 Lanes Mixed Use SFF SCN MK006400KWWFK SSD. Диски поставляются с салазками HPE, форм-фактор 2.5'. Повышенная надёжность DWPD 3, отличная производительность при чтении 610000 IOPS. Запись медленнее, но тоже прилично — 160000 IOPS.

HPE 6.4TB NVMe — MK006400KWWFK SSD

Странно, на дисках нет наклейки HPE, но прошивка, как оказалось, правильная стоит. Понятно, что диски теперь не стоят на гарантии производителя, гарантия только от поставщика. Салазки тоже какие-то покоцаные, ну да ладно, на мощщу не влияют.

Номер на салазках P51462, тоже не соответствует номерам уже установленных дисков, посмотрим на практике.

Готовлю два диска, выдвигаюсь в ЦОД.

Сервер в работе. У меня уже был негативный опыт, когда при установке NVMe диска в HPE сервера что-то пошло не так. Поэтому заранее предупреждаю заказчика, что возможна неожиданная перезагрузка.

Устанавливаю диски.

Сначала просто размещаю в направляющих.

Затем аккуратно вставляю. Проверяю в iLO что диски увиделись, а они увиделись. Проверяю в ОС, что диски увиделись. В первом сервере диски определились без проблем, во втором сервере пришлось выполнить перезагрузку.

mdadm — добавляем два диска в RAID10

Для проверки NVMe дисков используем пакет NVMe Command Line Interface (NVMe-CLI).

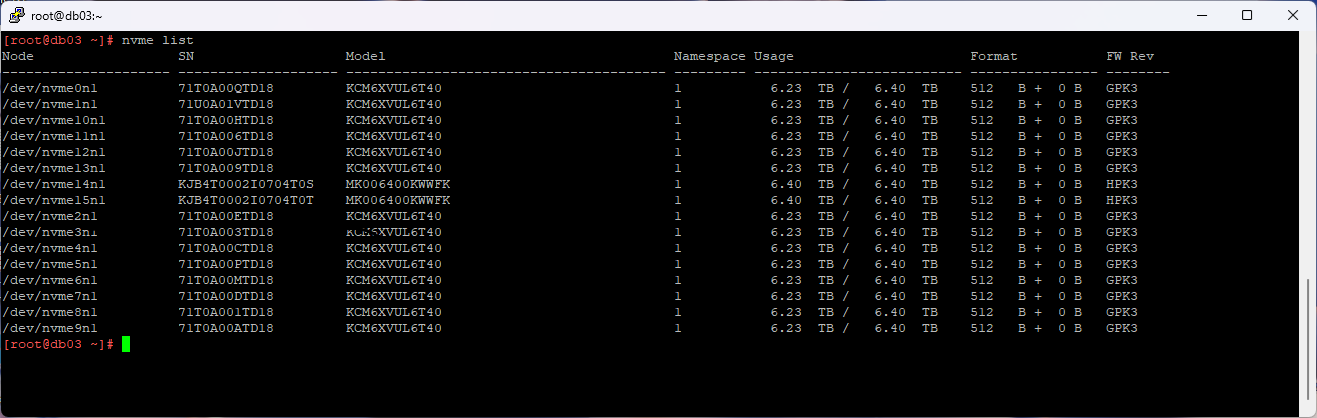

nvme listВ системе теперь шестнадцать дисков.

Новые диски:

- /dev/nvme14n1

- /dev/nvme15n1

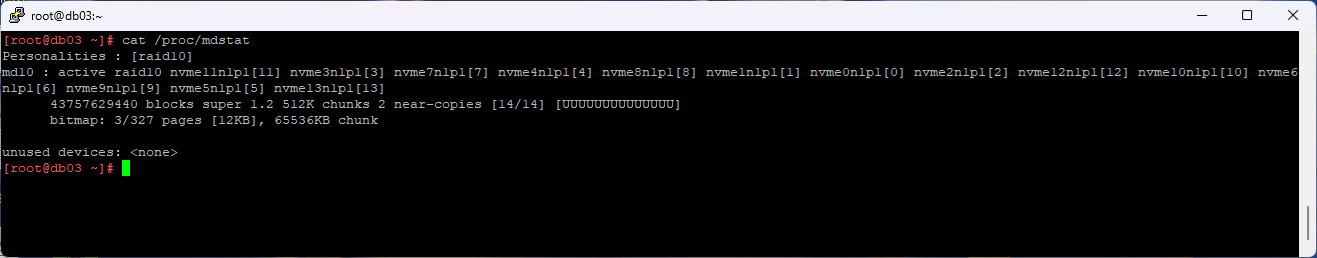

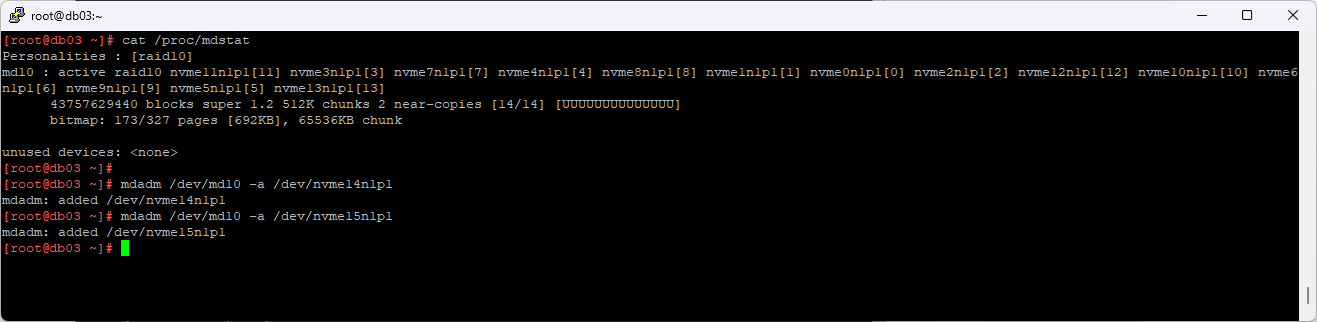

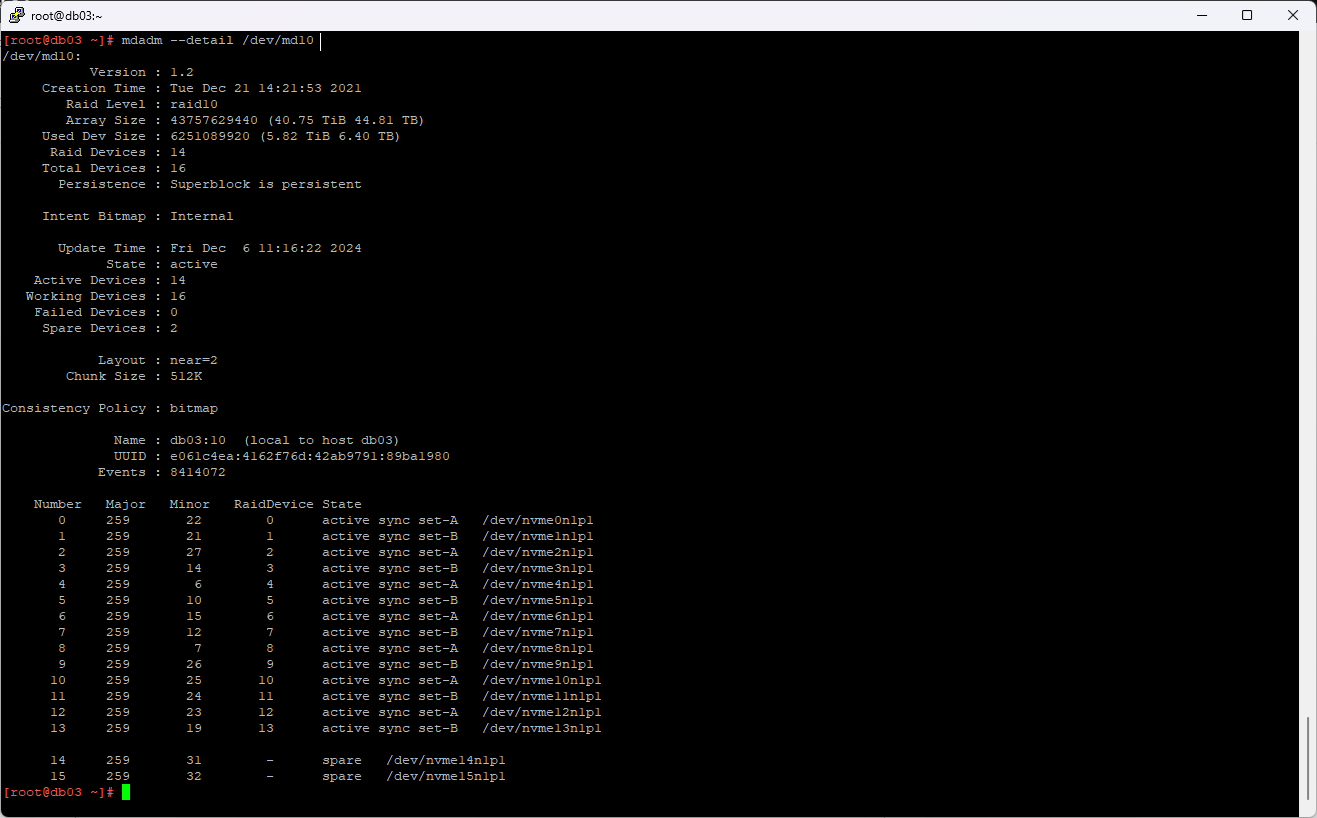

cat /proc/mdstatВ сервере собран массив md10 из 14 дисков.

Проверяем состояние массива.

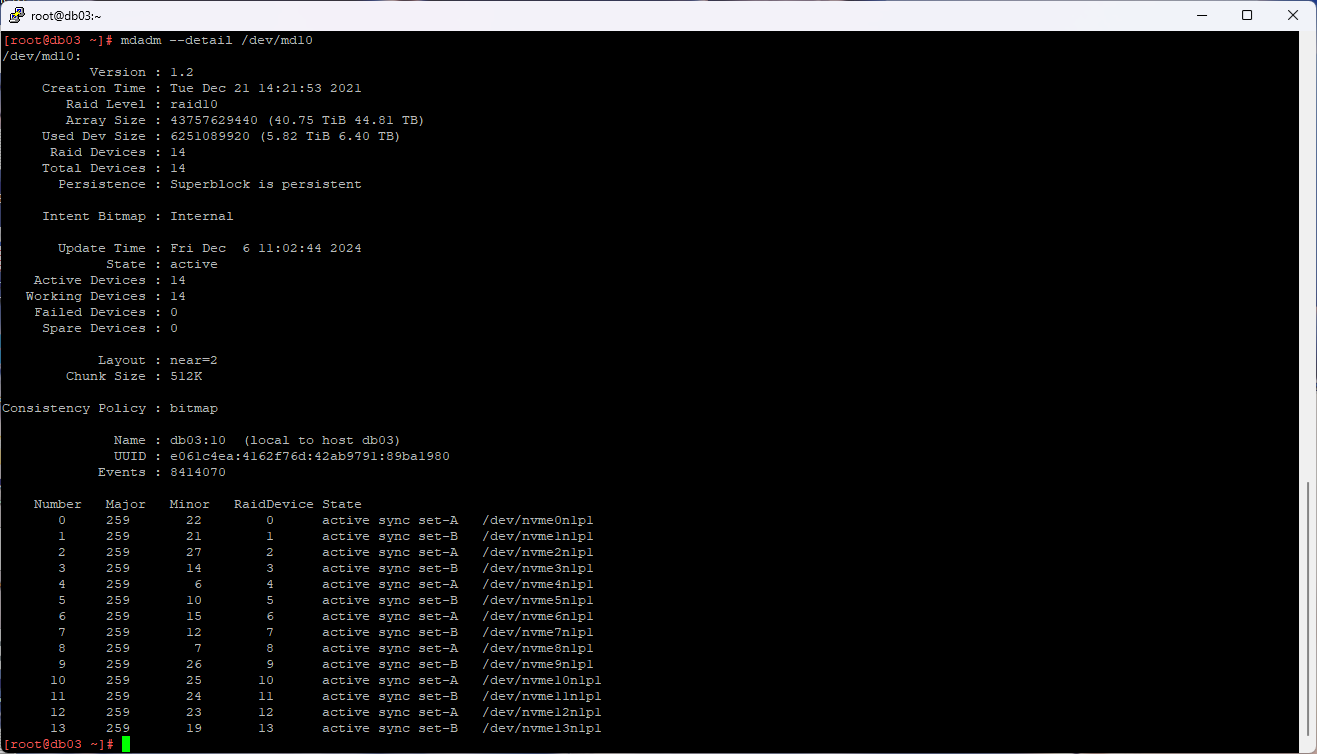

mdadm --detail /dev/md10

Массив работает. Зафиксируем текущий размер файловой системы массива.

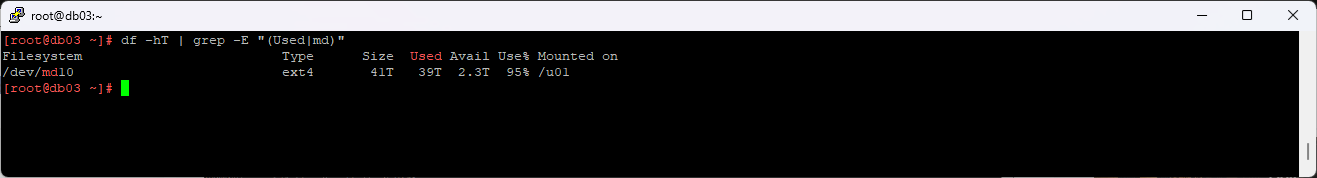

df -hT | grep -E "(Used|md)"41 ТБ, свободно 2.3 ТБ.

Диски будем добавлять по аналогии с существующими. Предварительно нужно создать на дисках разделы.

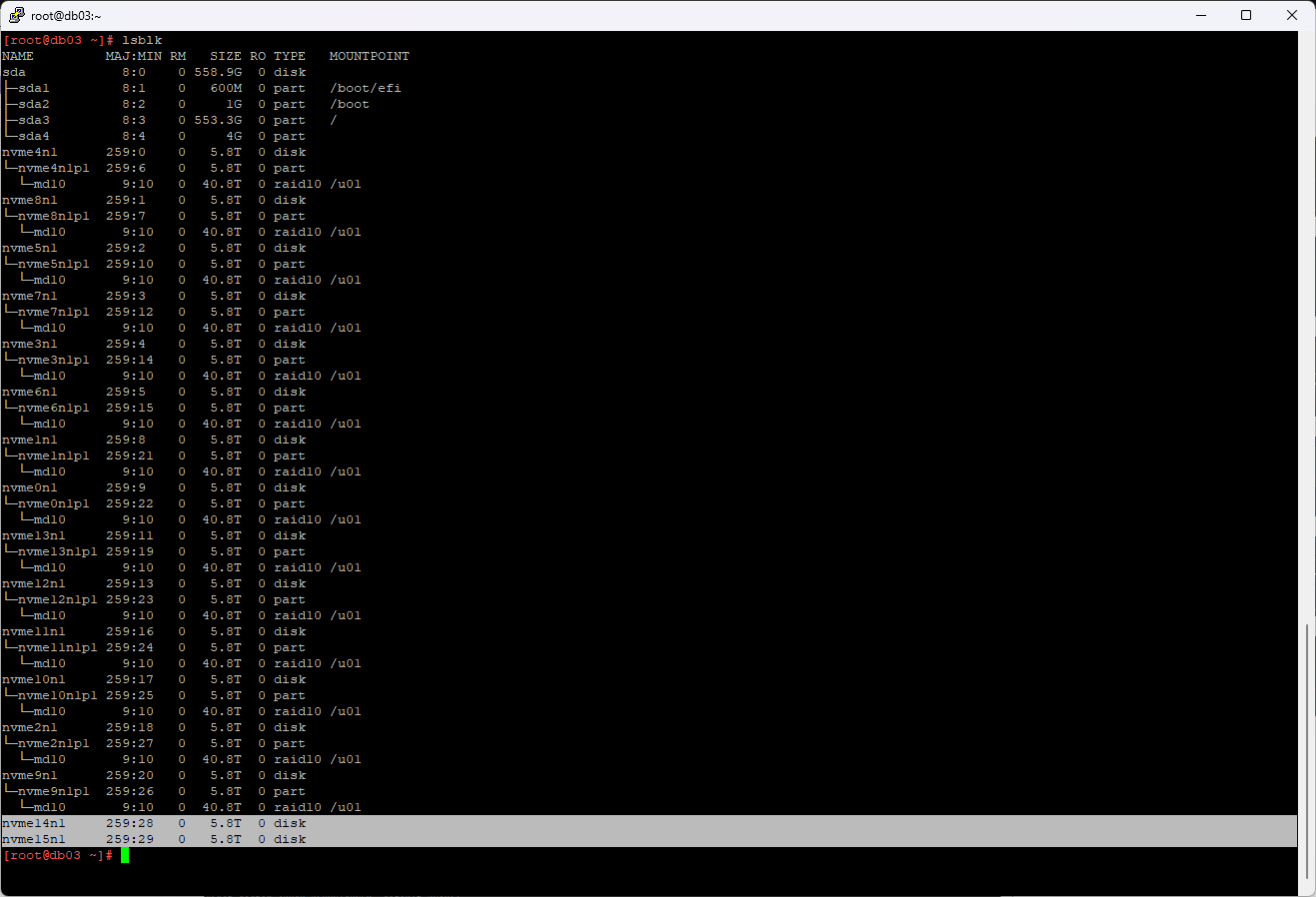

lsblk

Диски nvme14n1 и nvme15n1 без разделов. Для создания разделов используем fdisk.

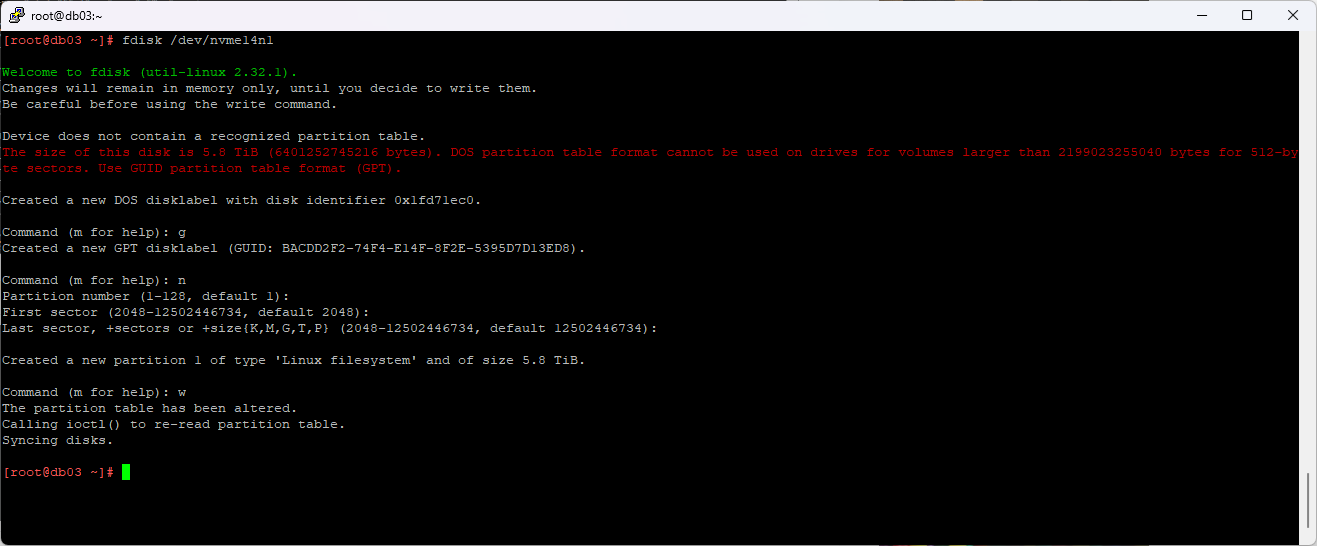

fdisk /dev/nvme14n1

g

n

w

Повторяем для второго диска.

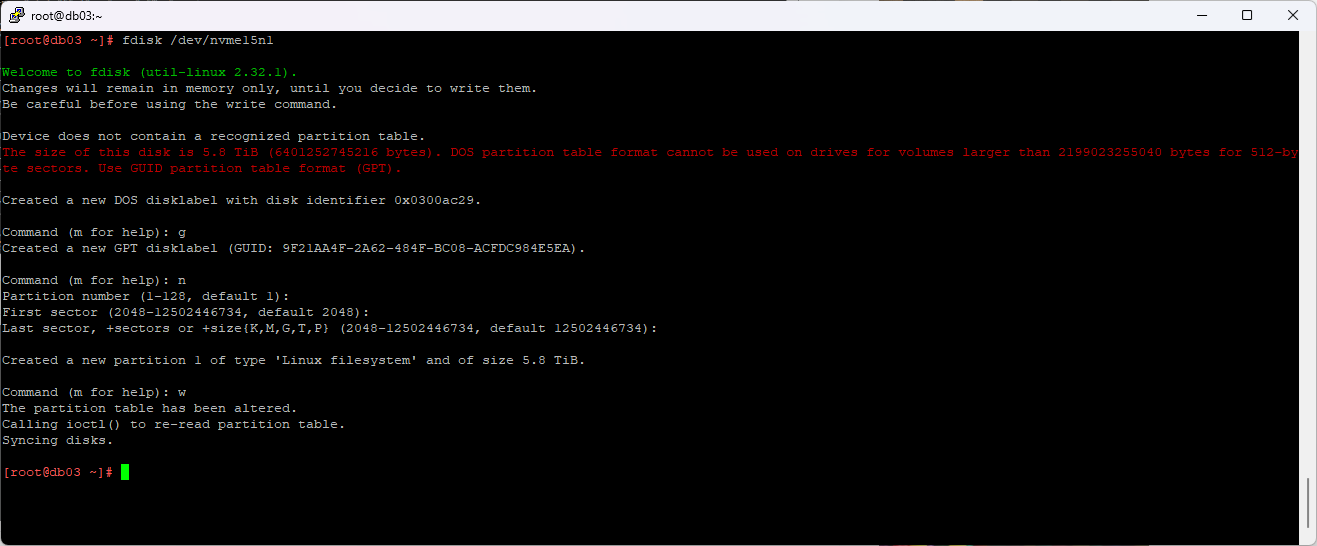

fdisk /dev/nvme15n1

g

n

w

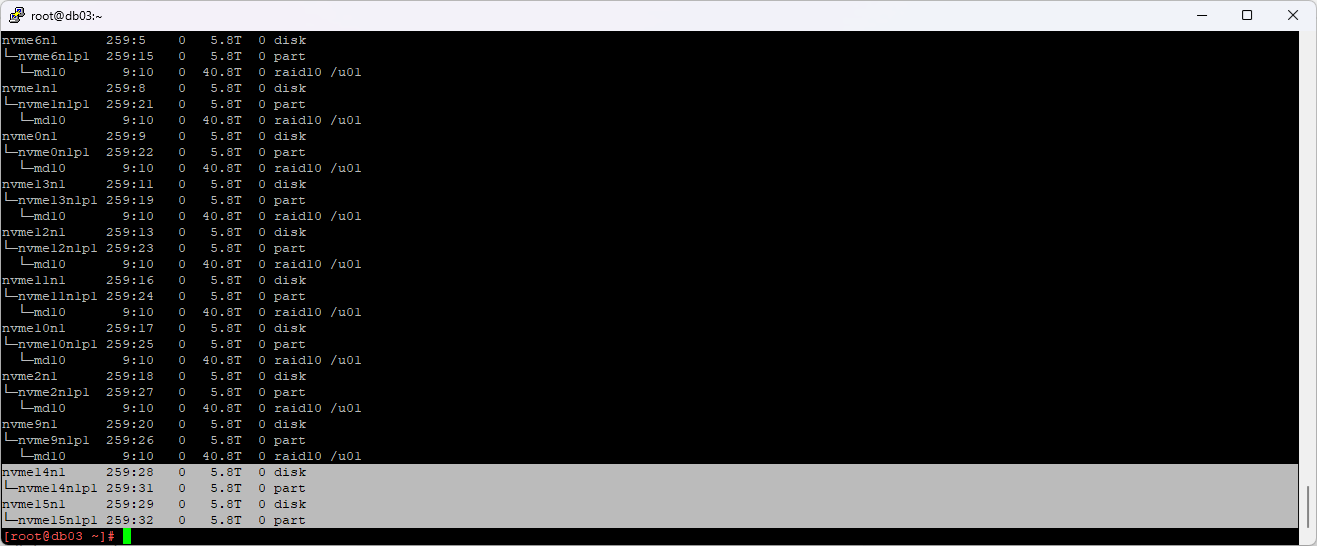

lsblk

Созданы разделы:

- /dev/nvme14n1p1

- /dev/nvme15n1p1

Добавляем оба новых раздела в массив:

mdadm /dev/md10 -a /dev/nvme14n1p1

mdadm /dev/md10 -a /dev/nvme15n1p1

Осмотрим массив.

mdadm --detail /dev/md30

Оба диска добавлены в качестве spare. Расширяем массив.

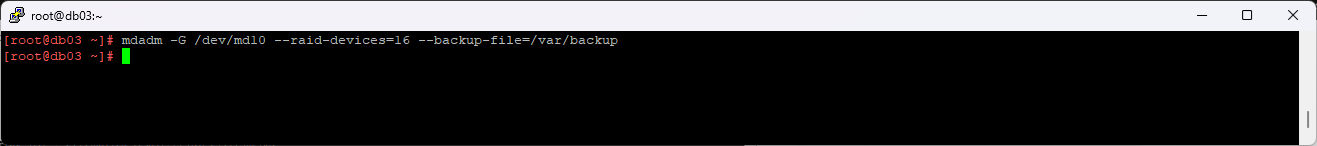

mdadm -G /dev/md10 --raid-devices=16 --backup-file=/var/backup

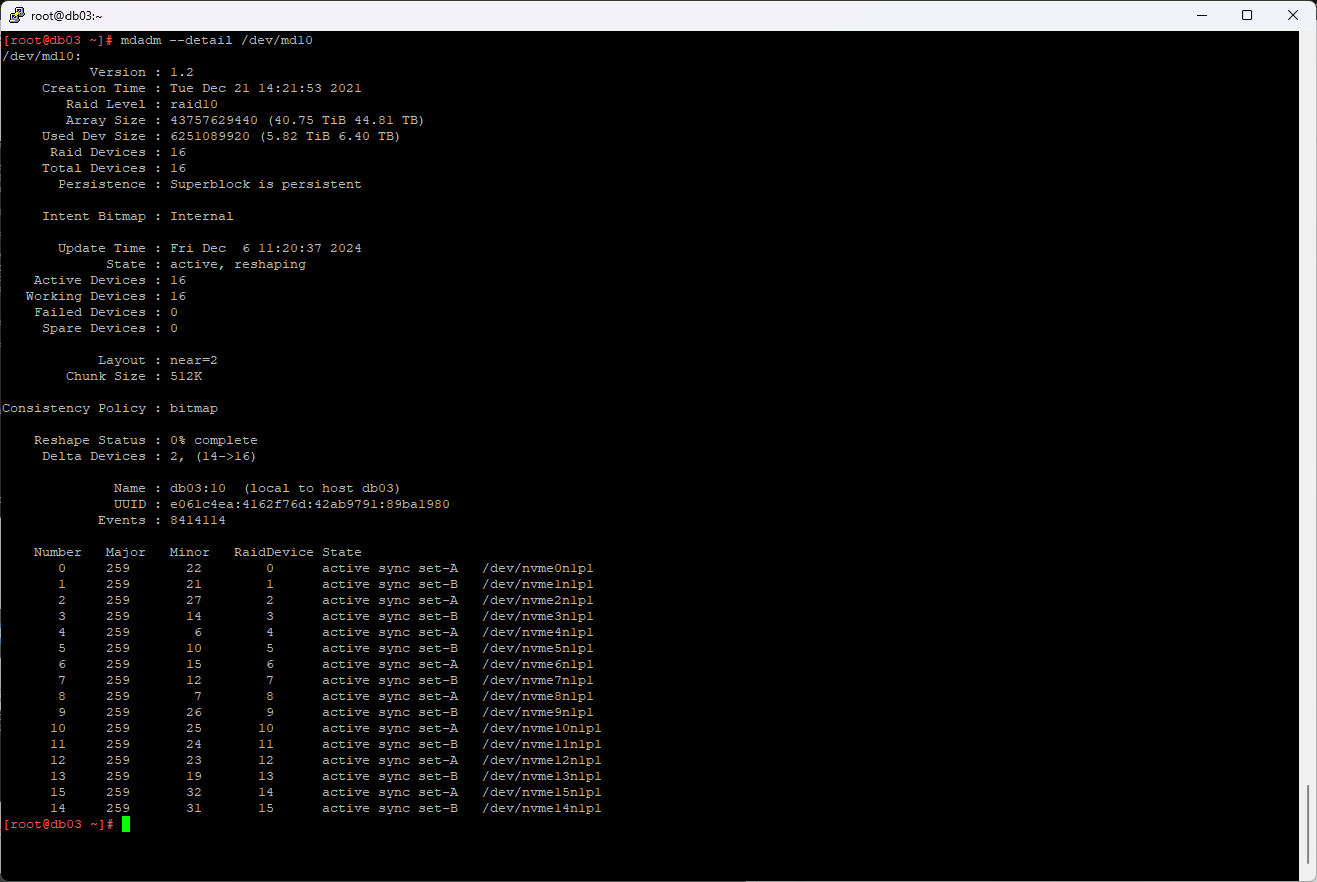

Проверяем.

mdadm --detail /dev/md10

Теперь в массиве шестнадцать активных дисков. Массив в состоянии reshaping.

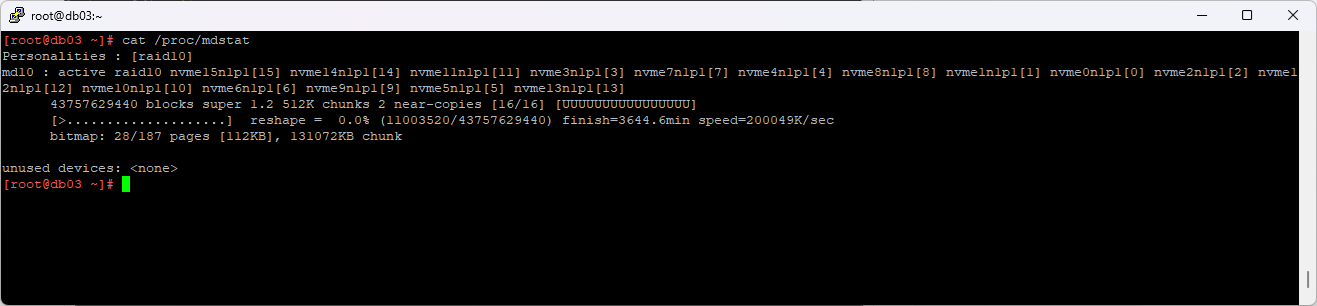

Процесс перестроения можно также отслеживать с помощью команды:

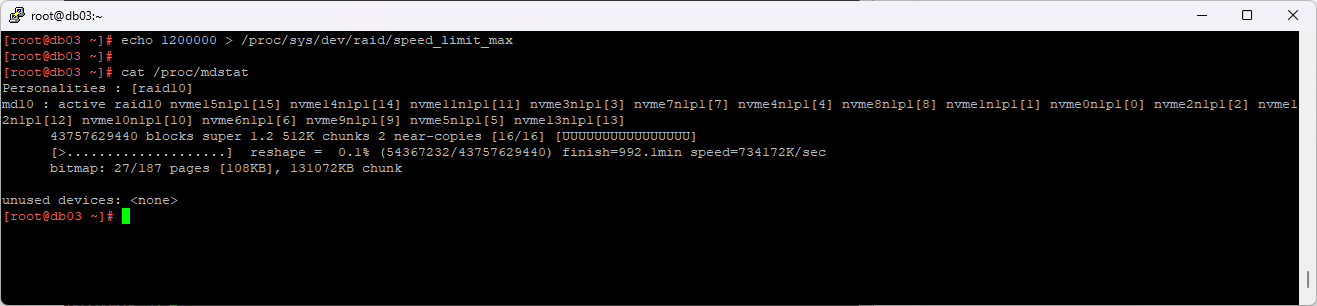

cat /proc/mdstat

Осталось 3644 минут, долго. Ускорим.

mdadm — увеличиваем скорость синхронизации массива

echo 1200000 > /proc/sys/dev/raid/speed_limit_max

После того как массив перестроится, нужно будет расширить файловую систему.

resize2fs /dev/md10

# или

xfs_growfs /путь_куда_примонтировано