Доброго времени суток. Сегодня мы будем добавлять СХД HPE MSA 2040 к серверу. Сервер у нас на базе Supermicro, модель значения не имеет. На борту операционная система Oracle Linux Server 7.9.

Задачка не так проста на первый взгляд. К серверу уже подключена одна СХД, которая презентует три тома серверу: mpatha, mpathb, mpathc.

- mpatha, устройство /dev/mapper/mpatha, алиас /dev/dm-0, размер 4.1 ТБ

- mpathb, устройство /dev/mapper/mpathb, алиас /dev/dm-1, размер 4.1 ТБ

- mpathc, устройство /dev/mapper/mpathc, алиас /dev/dm-2, размер 27 ТБ

Все три тома на сервере собраны в один общий диск с помощью LVM.

Собираем три разных multipath диска в один с помощью LVM

Наша задача — расширить текущий массив. Для этого нам придётся подключить СХД к серверу (по FC), создать на СХД два RAID10 массива по 10 дисков и добавить их к общему диску с помощью LVM. Два массива придётся создавать по той причине, что MSA 2040 не умеет создавать массивы более чем из 16 дисков, а у нас в СХД их 22 штуки. Два диска оставим в SPARE.

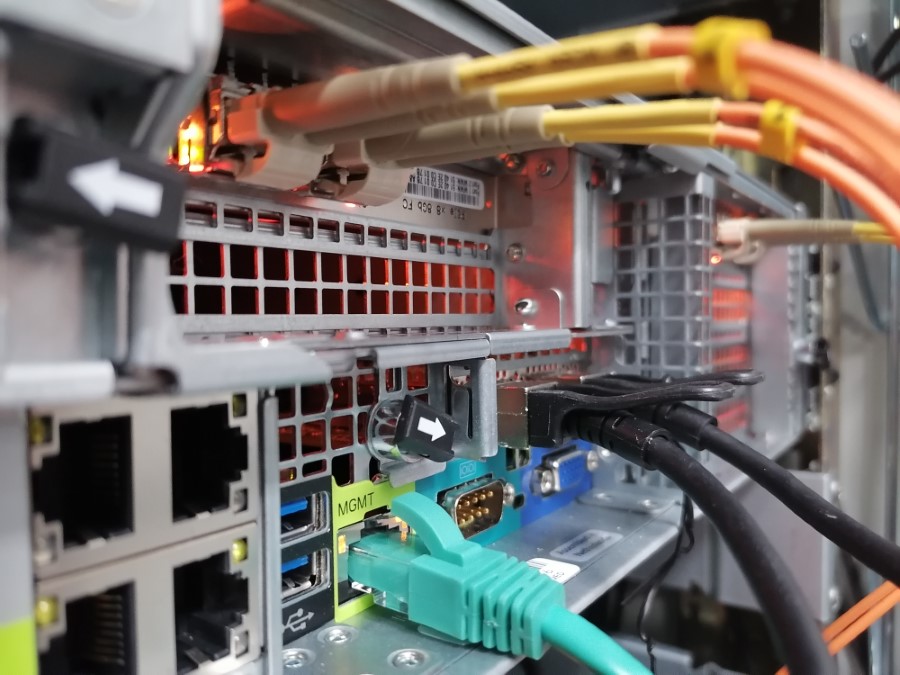

Аппаратная часть

Аппаратную часть мы пропускаем. Там ничего нет сложного. В сервере есть двупортовые Fibre Channel адаптеры с двумя свободными портами.

Контроллер HP 82Q 8Gb Dual Port PCI-e FC HBA —AJ764-63002

Подключаем их к HPE MSA 2040. Проверяем на сервере, что линки поднялись.

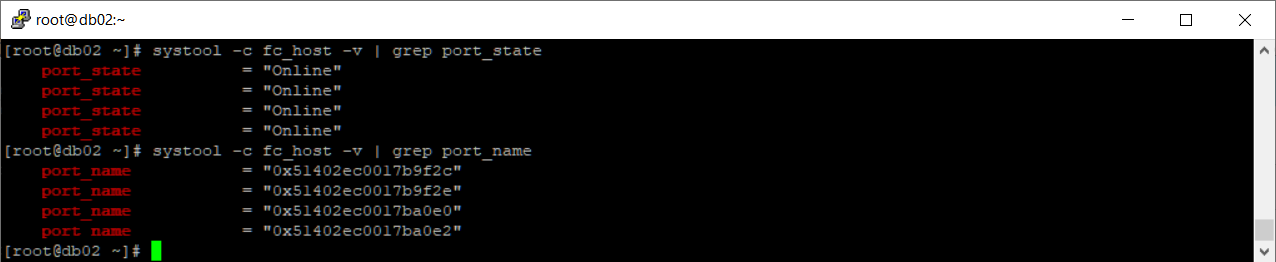

Linux — идентификация FC HBA портов

Статус портов.

systool -c fc_host -v | grep port_state

WWN идентификаторы.

systool -c fc_host -v | grep port_name

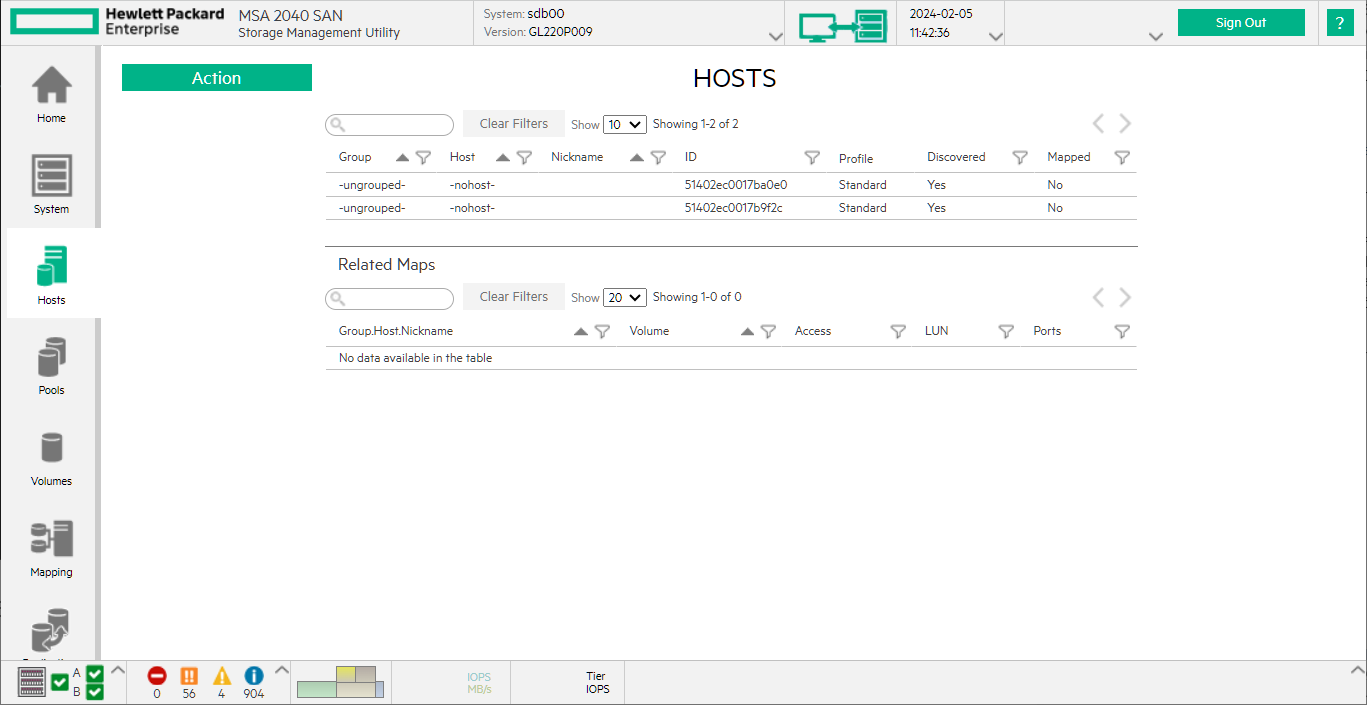

Проверяем доступность линков со стороны MSA.

Линки поднялись, аппаратная часть завершена.

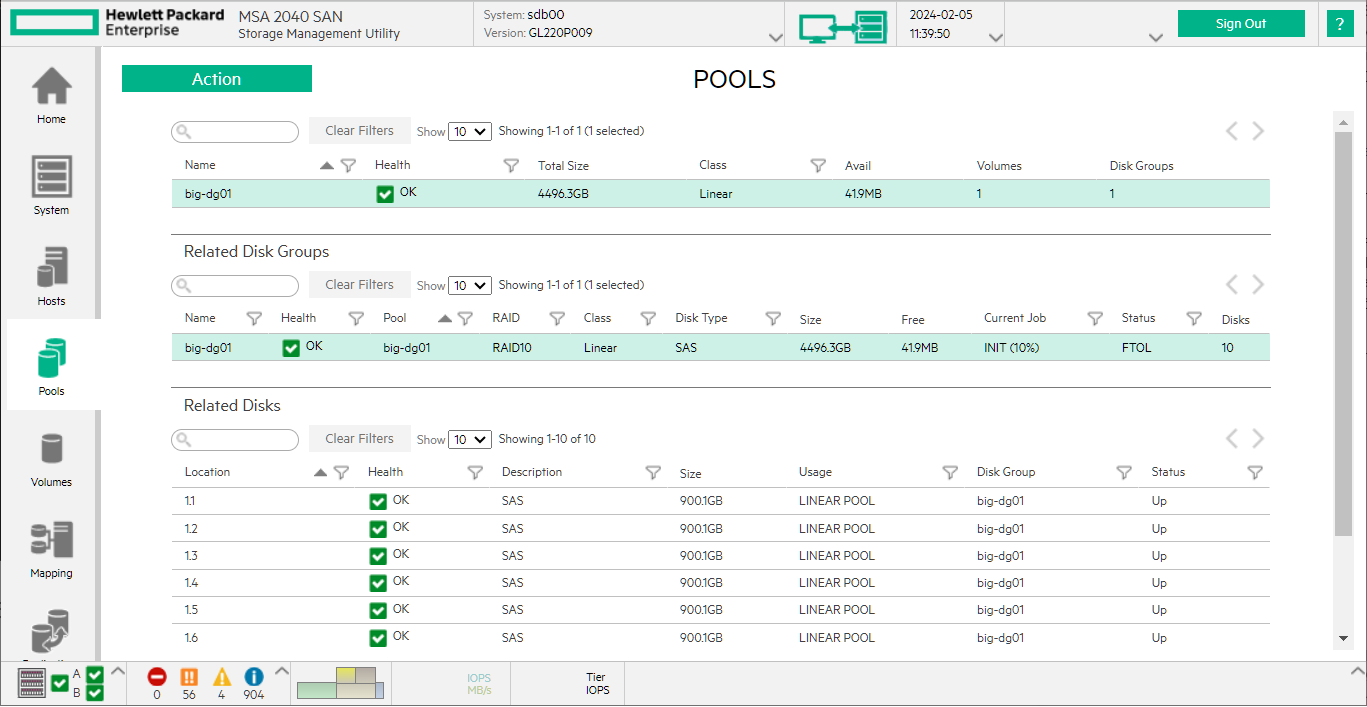

Создание массивов

Создаём первый линейный пул RAID10 из десяти дисков.

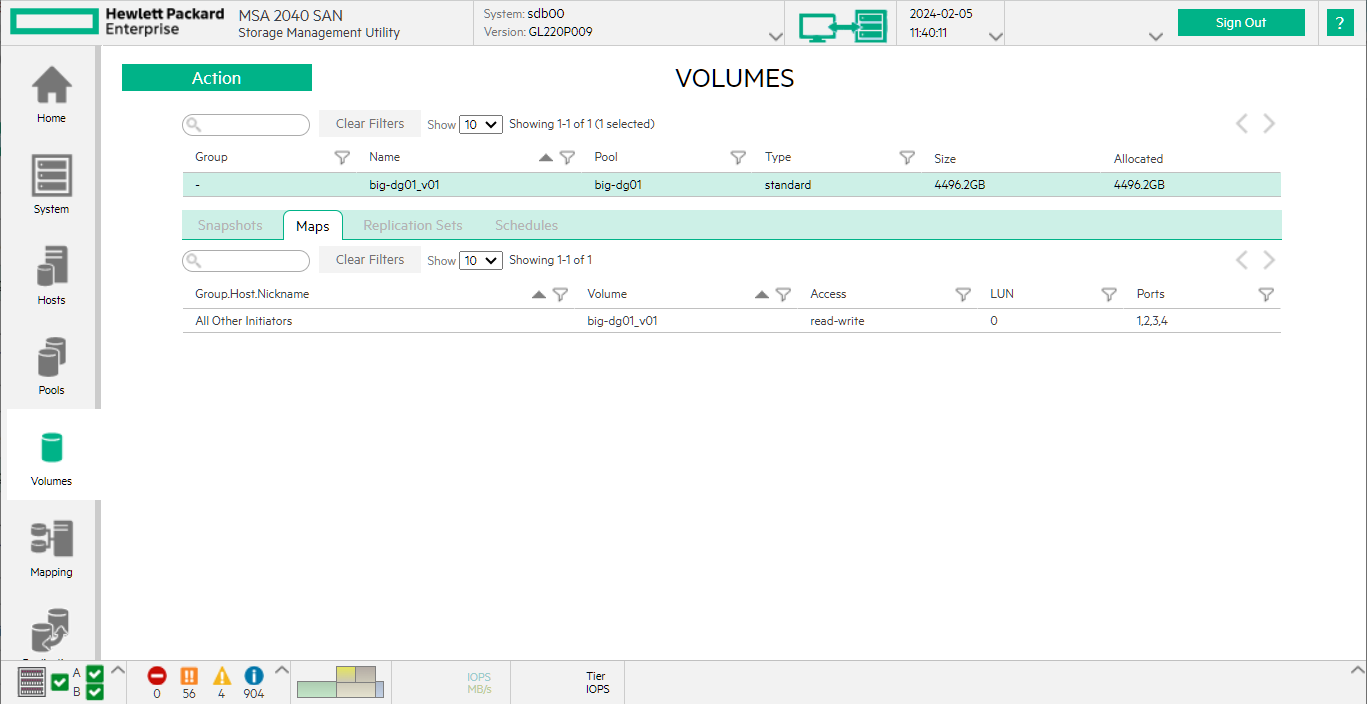

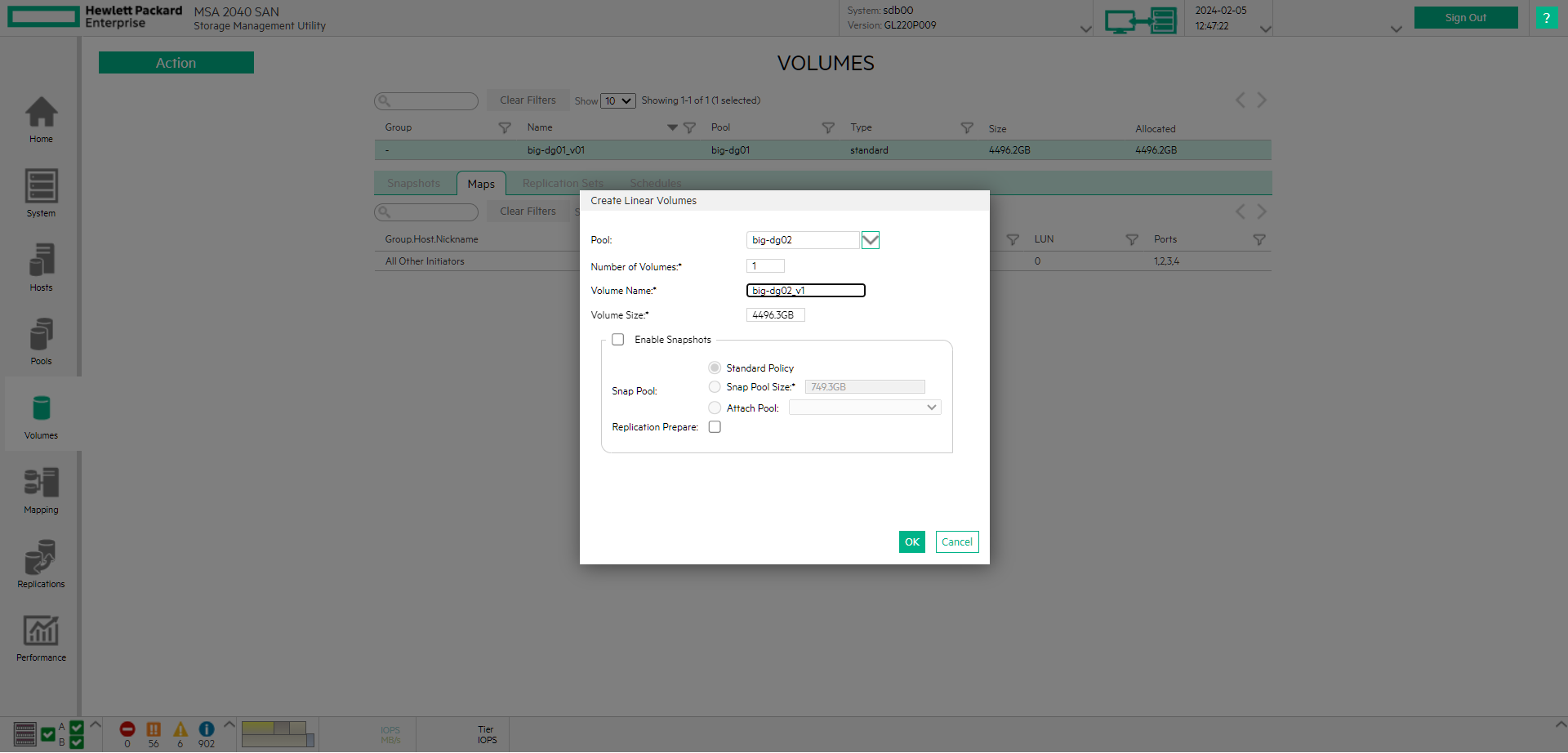

Создаём первый том.

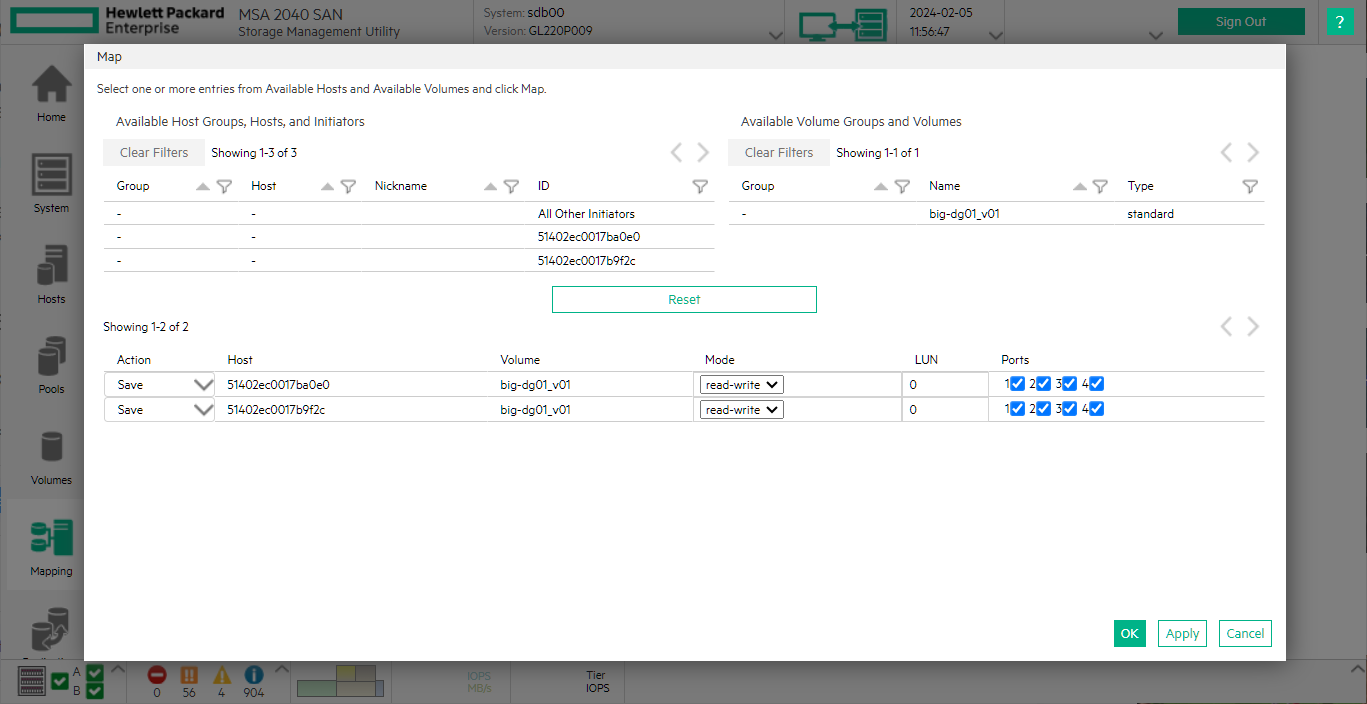

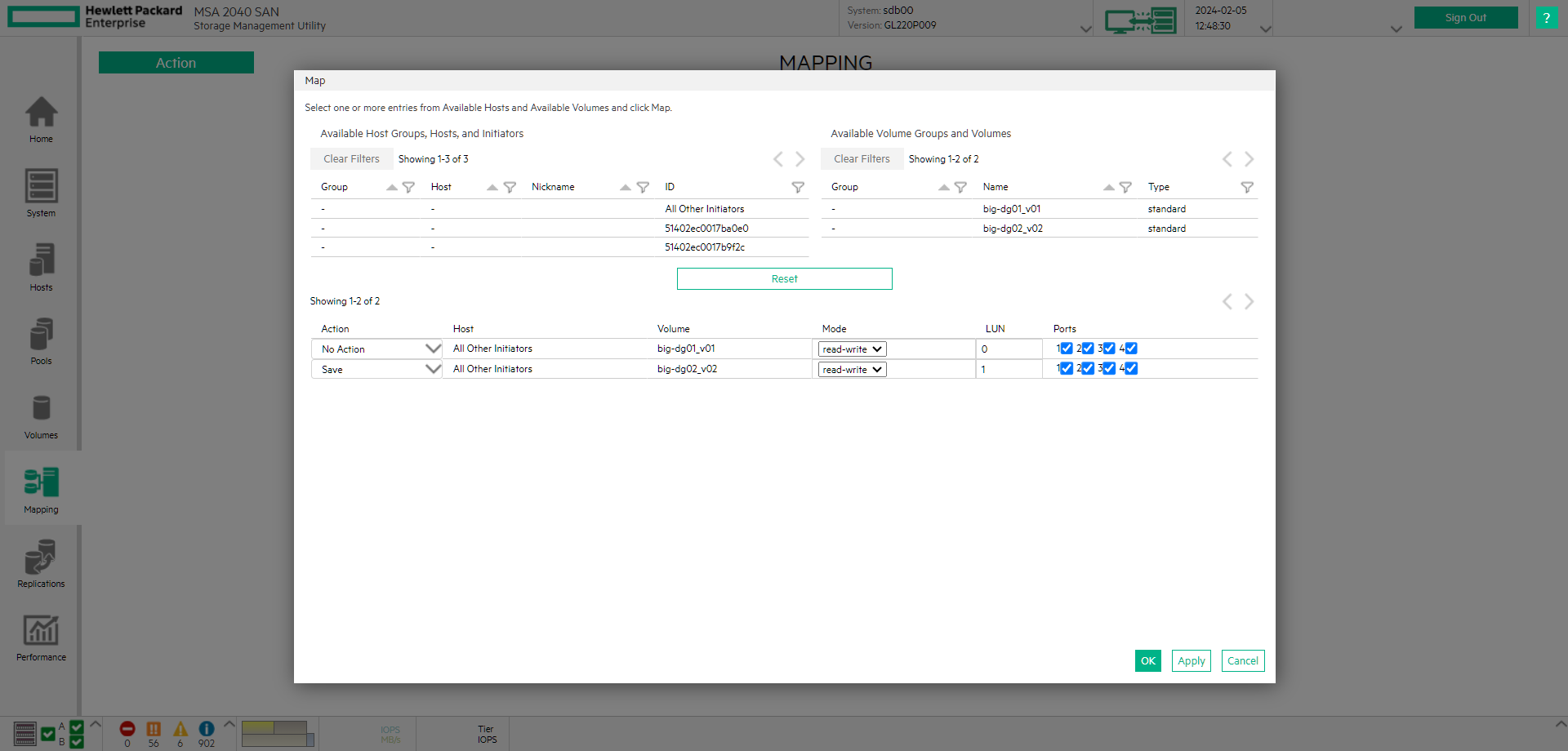

Разрешаем доступ на чтение/запись в первый том хосту.

На хосте через multipath добавляем диск.

Linux — добавляем multipath диск на лету

Проверим наличие нового устройства:

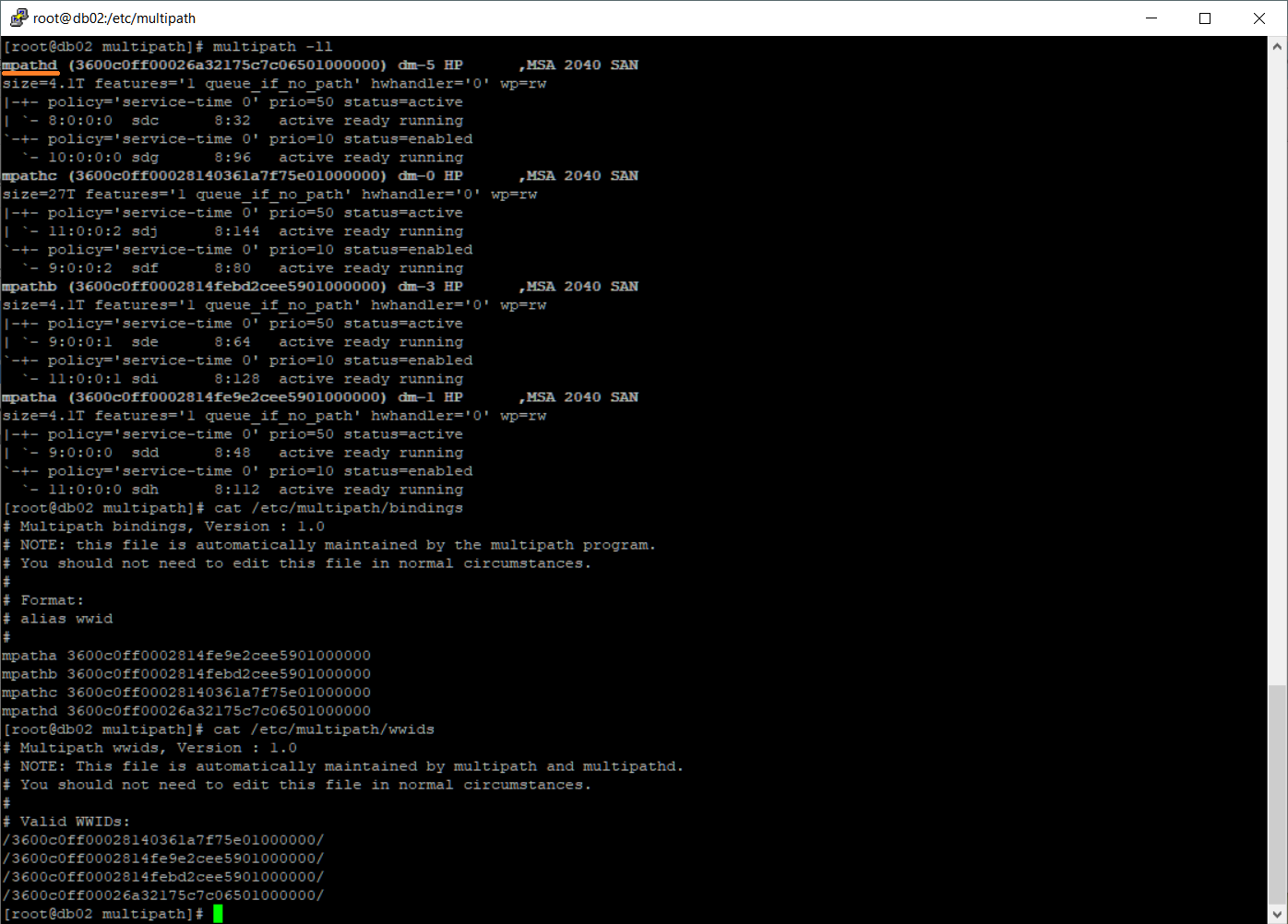

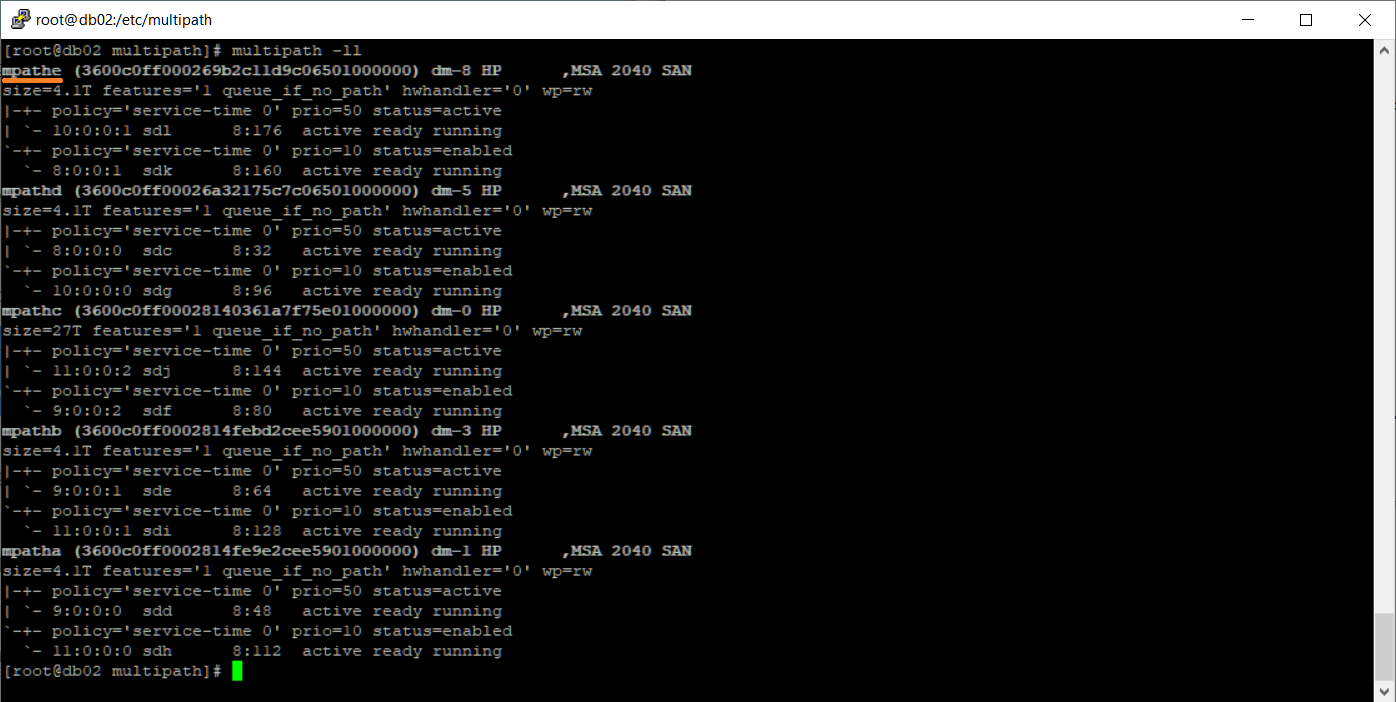

multipath -ll

cat /etc/multipath/bindings

cat /etc/multipath/wwids

Появилось новое устройство:

- mpathd, устройство /dev/mapper/mpathd, алиас /dev/dm-5, размер 4.1 ТБ

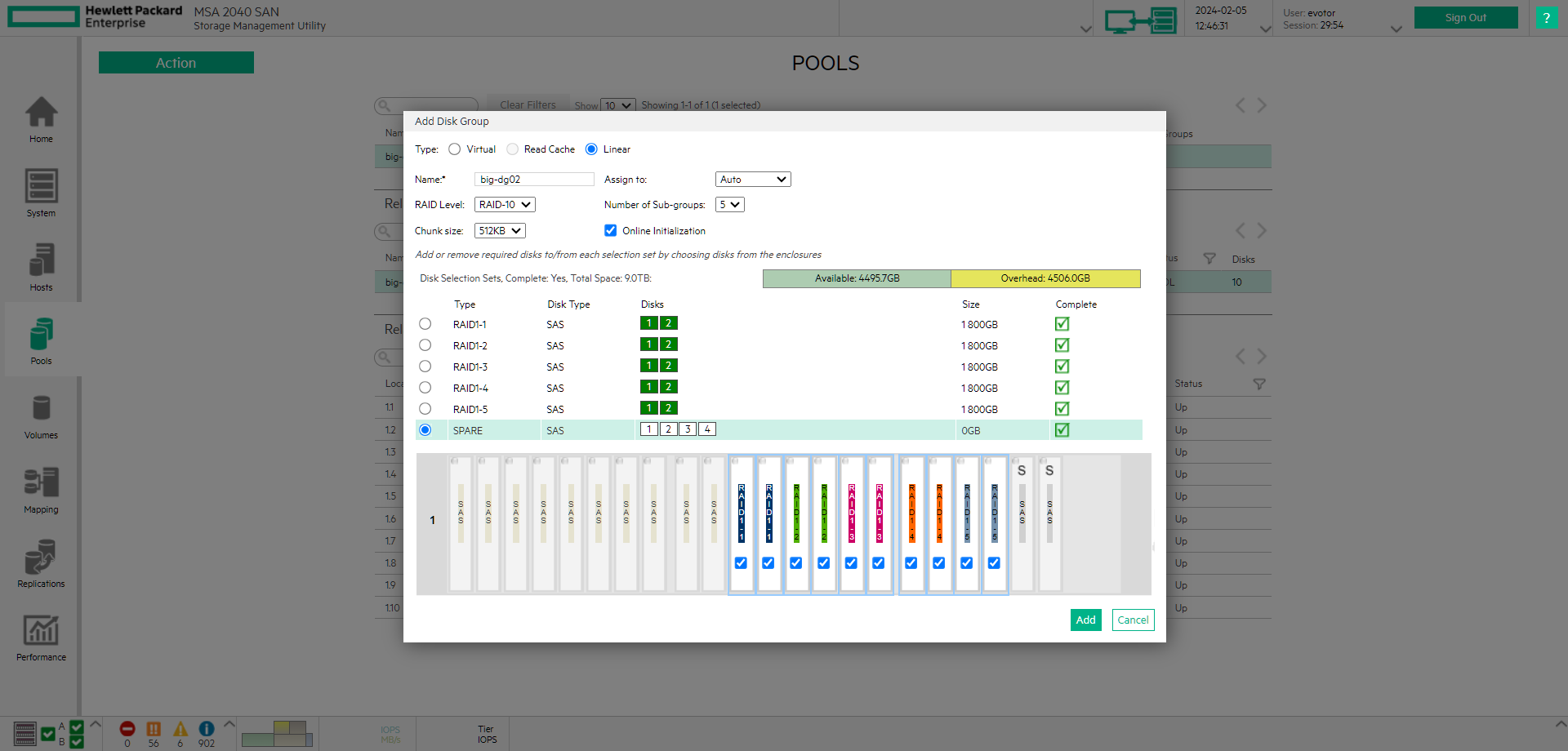

Создаём второй линейный пул RAID10 из десяти дисков.

Создаём второй том.

Разрешаем доступ на чтение/запись хосту.

На хосте через multipath добавляем диск. Проверим наличие нового устройства:

multipath -ll

Появилось новое устройство:

- mpathe, устройство /dev/mapper/mpathe, алиас /dev/dm-8, размер 4.1 ТБ

Добавляем два разных multipath диска в существующий с помощью LVM

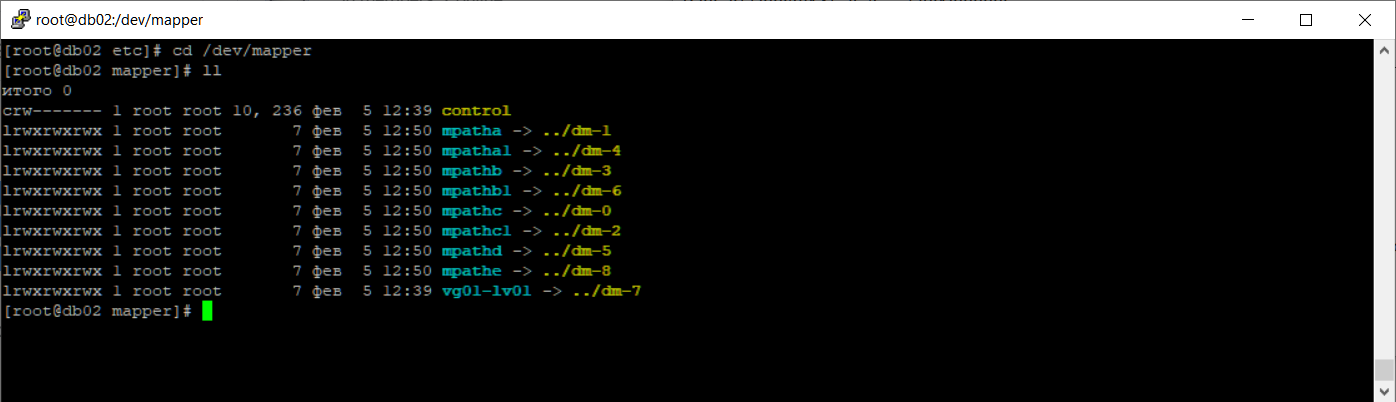

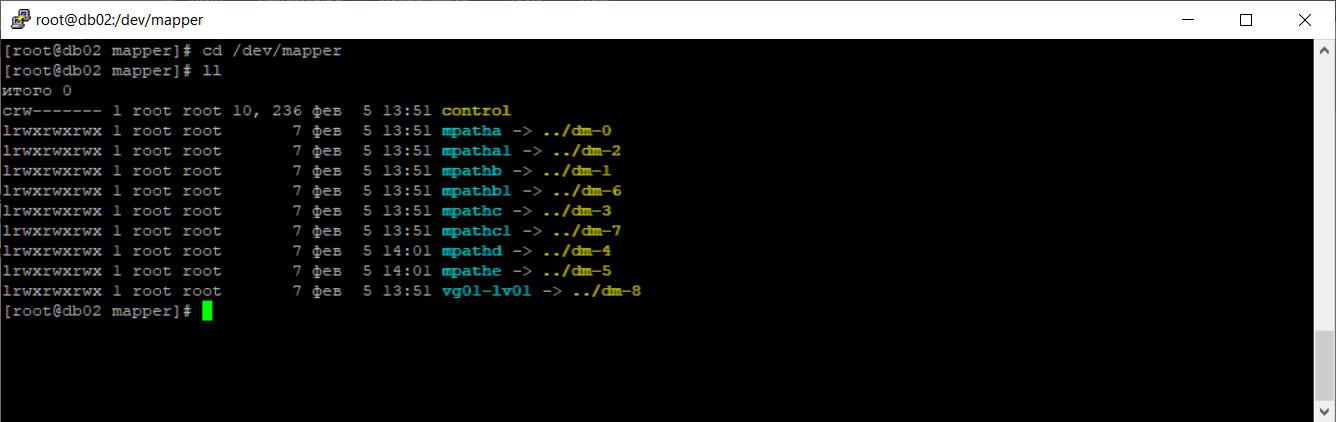

Посмотрим на наши диски.

cd /dev/mapper

ll

Видно, что на новых устройствах dm-5 и dm-8 нет разделов. Эти названия не статические, они, скорее всего, после перезагрузки изменятся. Давайте проверим и перезагрузим сервер.

cd /dev/mapper

ll

Ну вот, устройства теперь dm-4 и dm5.

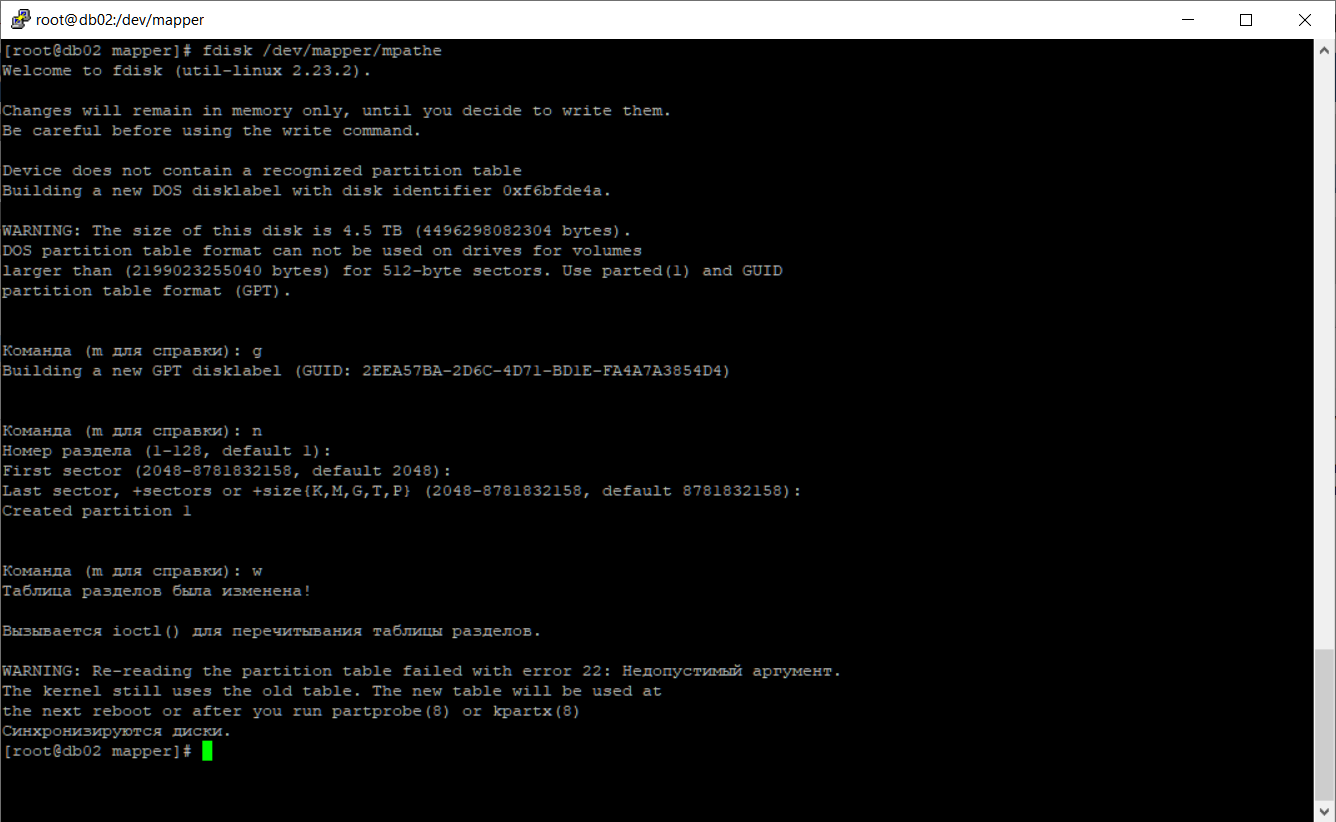

Создадим разделы с помощью fdisk.

fdisk /dev/mapper/mpathd

g

n

w

fdisk /dev/mapper/mpathe

g

n

w

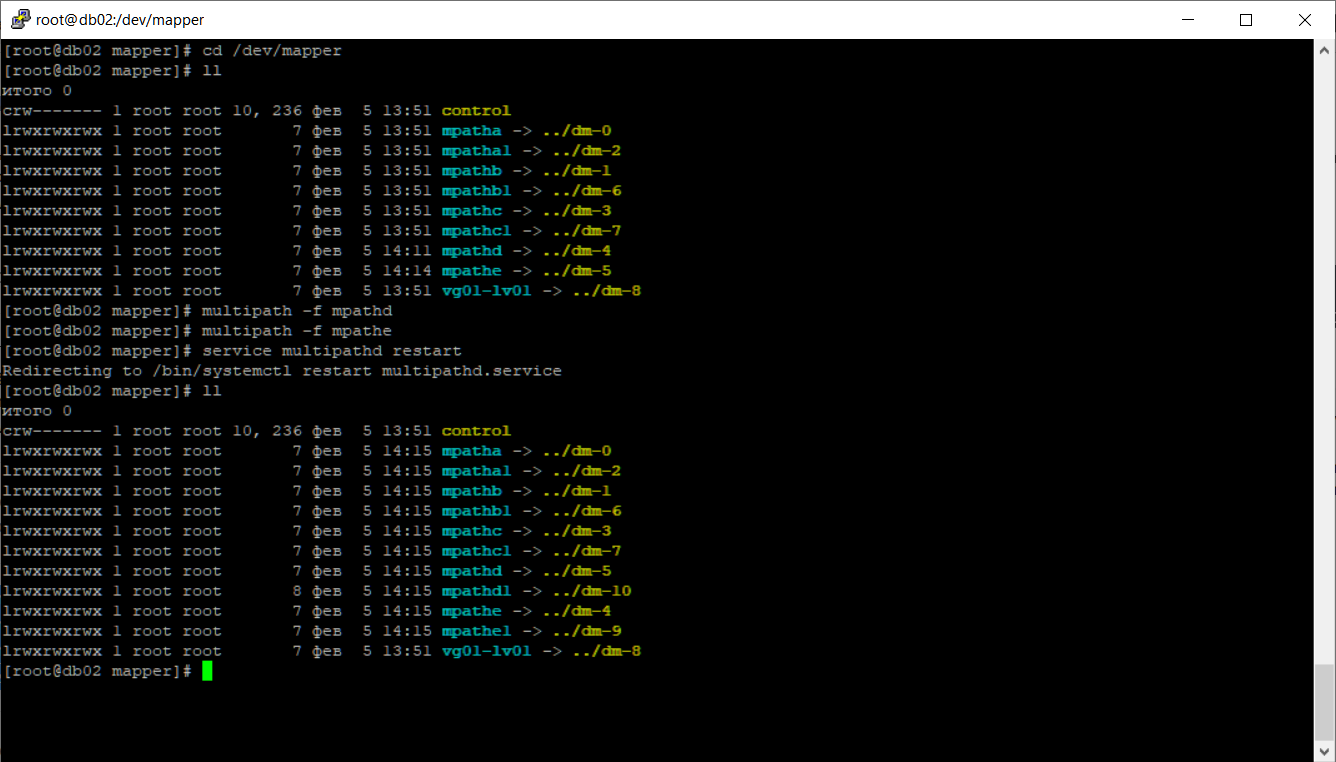

Выкидываем новые диски и перезапускаем службу multipath.

multipath -f mpathd

multipath -f mpathe

service multipathd restart

cd /dev/mapper

ll

На дисках появились разделы:

- /dev/mapper/mpathd1

- /dev/mapper/mpathe1

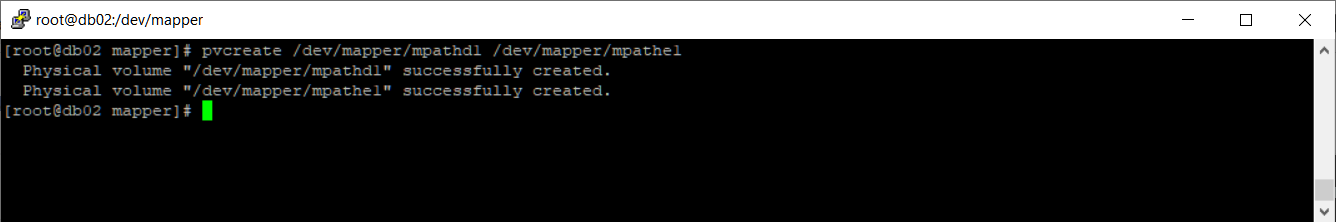

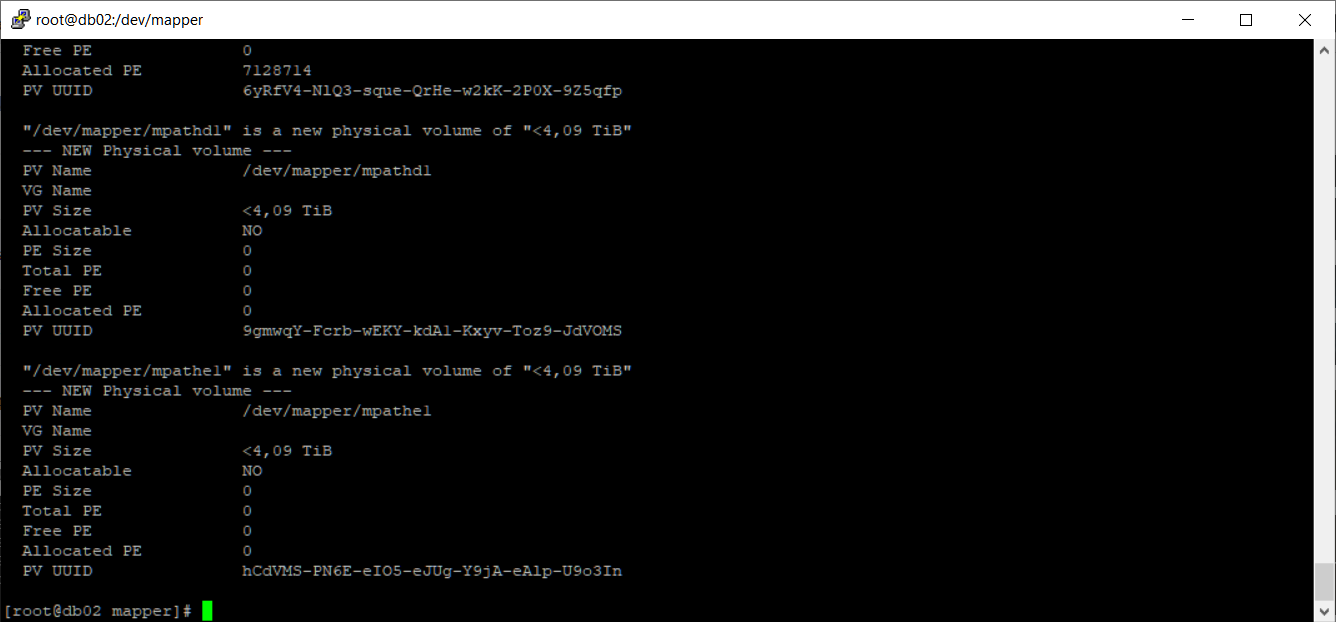

Создаём два физических тома:

pvcreate /dev/mapper/mpathd1 /dev/mapper/mpathe1

Физически тома LVM созданы. Посмотрим на них:

pvdisplay

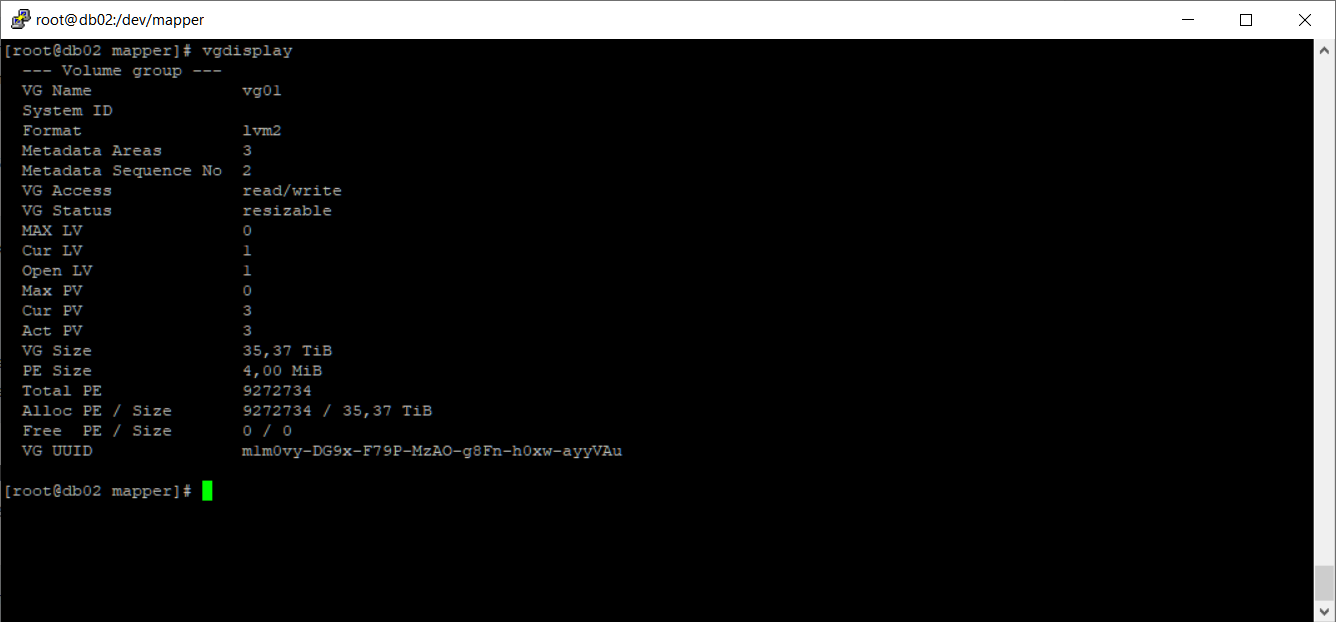

Посмотрим как называется текущая группа томов:

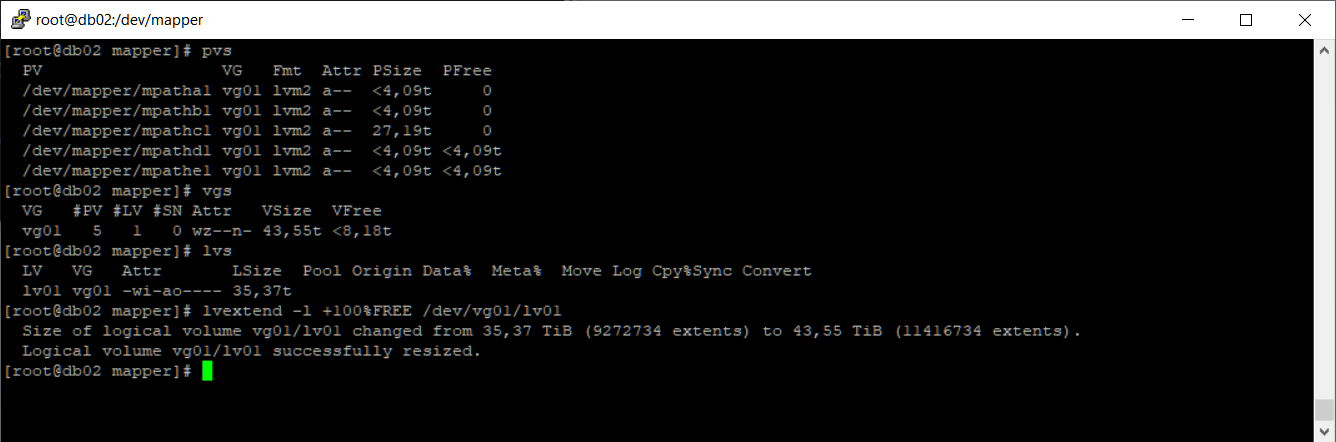

vgdisplay

Называется она у нас vg01. Текущий размер VG Size: 35,37 TiB.

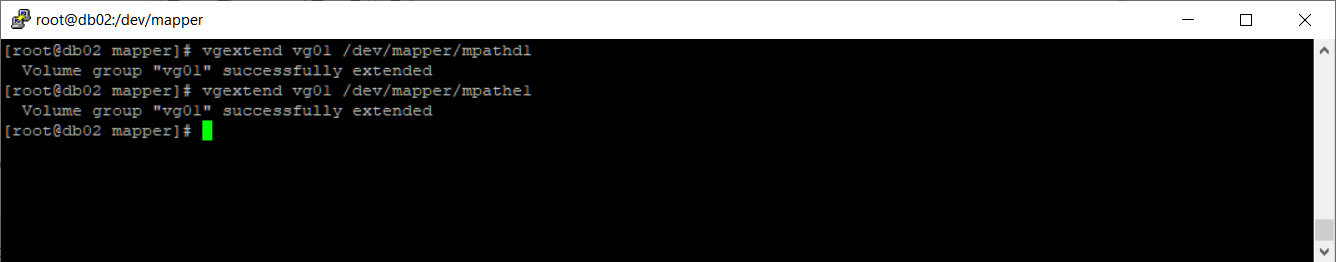

Расширим её, добавим в неё новые разделы.

vgextend vg01 /dev/mapper/mpathd1

vgextend vg01 /dev/mapper/mpathe1

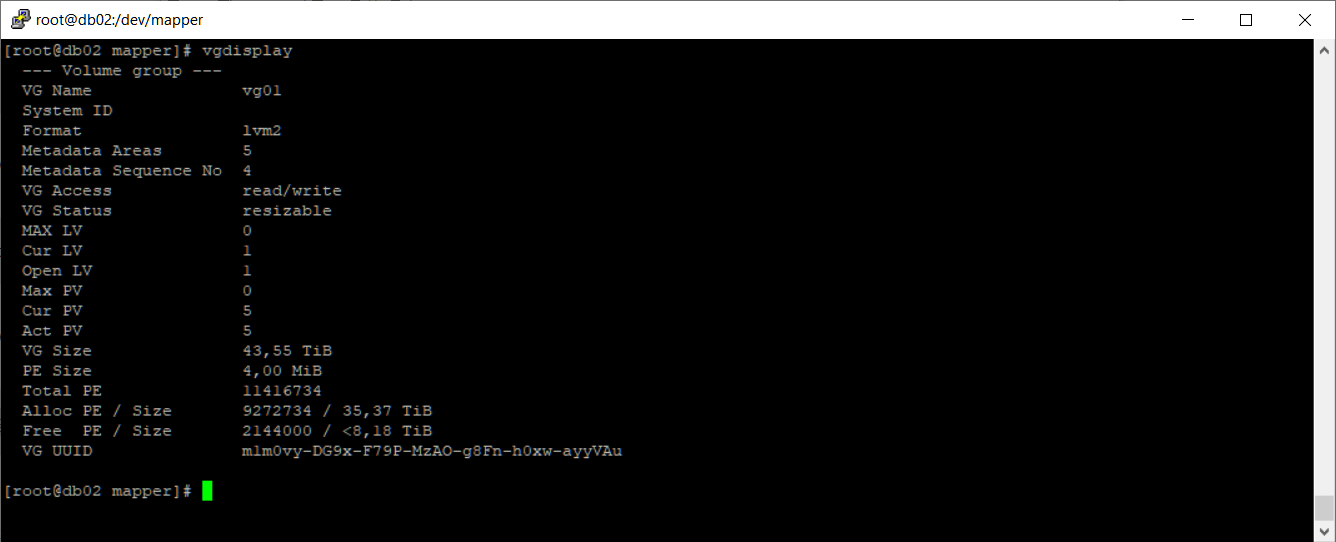

vgdisplay

Размер VG Size увеличился: 43,55 TiB.

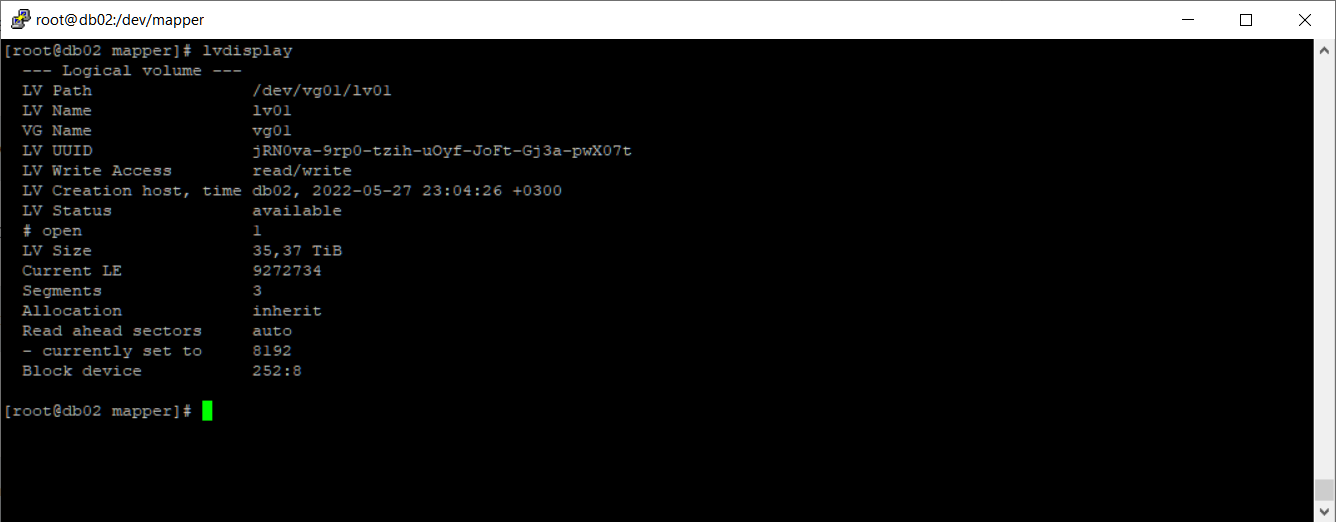

Посмотрим на логический том:

lvdisplay

LV Path: /dev/vg01/lv01. LV Size: 35,37 TiB. Расширим логический том.

lvextend -l +100%FREE /dev/vg01/lv01

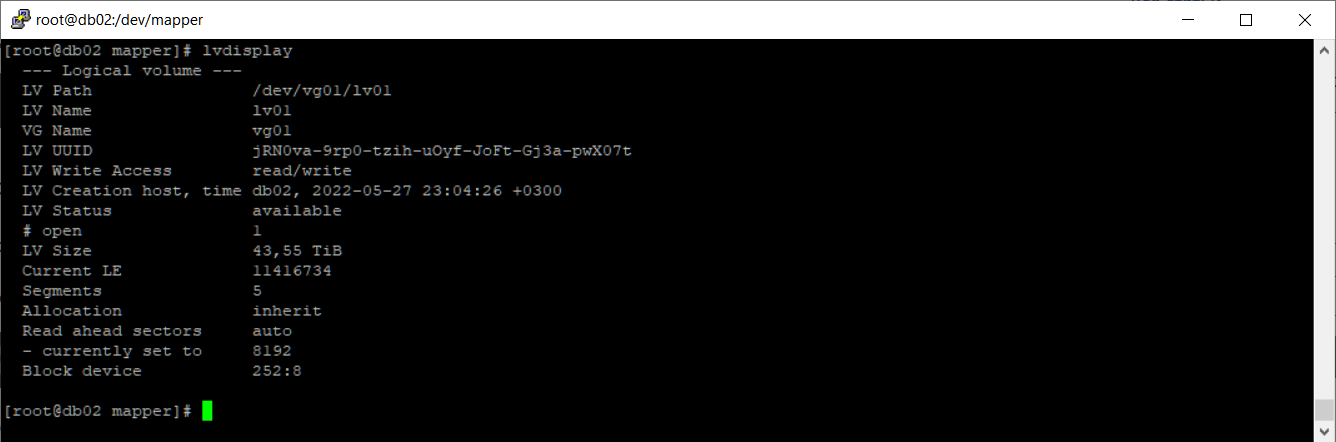

lvdisplay

Размер логического тома LV Size увеличился: 43,55 TiB.

С LVM закончили.

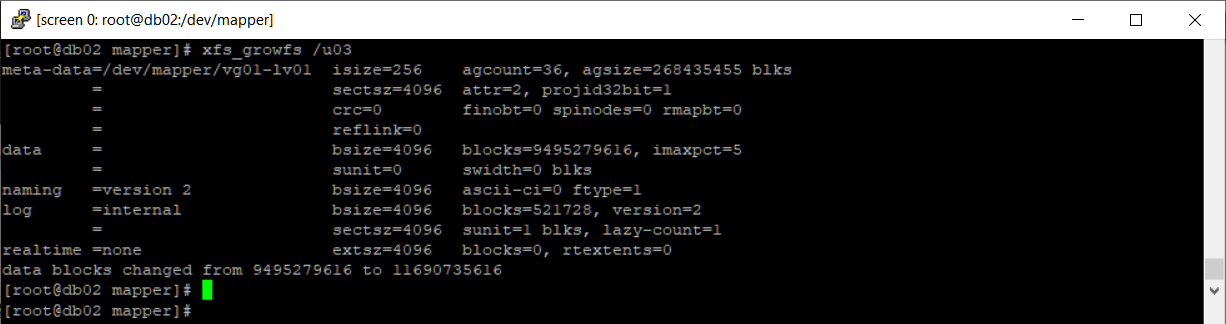

Расширяем файловую систему

Посмотрим куда у нас всё это добро смонтировано:

df -hT

Устройство /dev/mapper/vg01-lv01 смонтировано в директорию /u03, файловая система XFS. Расширяем файловую систему:

xfs_growfs /u03

Заключение

Мы с вами сделали доброе дело. Подключили СХД HPE MSA 2040 к серверу по Fibre Channel, создали RAID10 массивы, добавили их в операционную систему с помощью multipath. После этого расширили текущий LVM диск и файловую систему.